Южнокорейскому институту объявили бойкот за разработку вооружений на базе ИИ

Более 50 ведущих экспертов в области разработки искусственного интеллекта сообщили о намерении бойкотировать Корейский институт передовых технологий (KAIST) – престижный и ведущий учебно-исследовательский университет Южной Кореи — за создание лаборатории по разработке вооружений с использованием искусственного интеллекта. Об этом они сообщили в открытом письме.

Возмущение экспертов области ИИ вызывало также и подписанное KAIST соглашение с оружейной компанией Hanwha Systems, которая, как сообщают различные источники, уже занимается разработками мощных видов вооружения, в числе которых, помимо прочего, имеются кассетные авиабомбы, запрещенные в соответствии с Конвенцией ООН по кассетным боеприпасам (Южная Корея эту конвенцию не подписала).

«В то время как Организация Объединённых Наций ведет обсуждение вопроса о том, как сдержать угрозу для международной безопасности со стороны автономных видов вооружения, вызывает сожаление тот факт, что такой престижный университет, как KAIST, ищет способы ускорить гонку вооружений через новые разработки подобных типов вооружения», — пишут эксперты ИИ в своем открытом письме.

«Поэтому мы публично заявляем, что будем бойкотировать все виды сотрудничества с любыми подразделениями KAIST до тех пор, пока президент KAIST не предоставит заверения в том, что центр не будет заниматься разработками автономных видов вооружения, чье функционирование возможно без значительного участия человека».

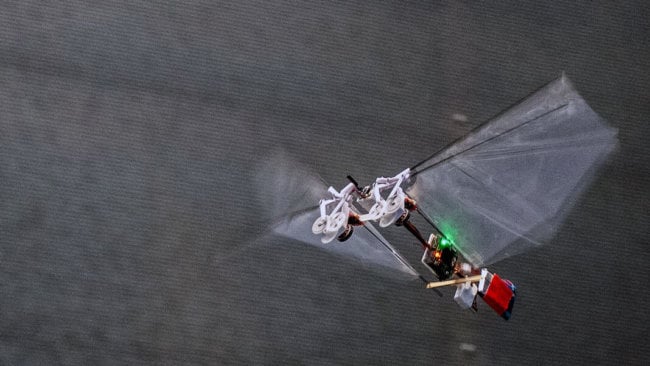

KAIST имеет в своем распоряжении одни из лучших в мире робототехнические и научные лаборатории: здесь проводятся исследования и разработки самых различных продвинутых технологий, начиная от жидких батарей и заканчивая медицинским оборудованием.

Глава KAIST Син Сон Чоль сказал, что он опечален решением о бойкоте, добавив, что институт не собирается создавать роботов-убийц.

«Как академическое учреждение, мы очень ценим человеческие права и этические стандарты. KAIST не собирается проводить исследовательскую деятельность, противоречащую принципам человеческого достоинства, в том числе и вести разработку автономного вооружения, не требующего человеческого контроля», — прокомментировал Син Сон Чоль в своем официальном заявлении по поводу бойкота.

Учитывая столь быстрые темпы развития аппаратных и программных средств, многие эксперты обеспокоены тем, что рано или поздно мы создадим нечто, что будем не в состоянии контролировать. Илон Маск, Стив Возняк, почивший недавно Стивен Хокинг и многие другие весьма видные фигуры в сфере IT-технологий в свое время призывали правительства стран и ООН наложить ограничения на разработки систем вооружения, управляемых ИИ.

По мнению многих, если мы придем к ракетам и бомбам, чье функционирование станет возможно независимо от человеческого контроля, то последствия этого могут оказаться ужасающими, особенно если такие технологии попадут не в те руки.

«Создание автономного вооружения приведет к третьей революции в военном деле. Подобные технологии позволят вести более стремительные, разрушительные и масштабные военные конфликты», — отмечают авторы открытого письма.

«Эти технологии имеют потенциал превращения в оружие террора. Диктаторы и террористы смогут использовать их против невинных групп населения, игнорируя любые этические аспекты. Это настоящий ящик Пандоры, закрыть который, в случае его открытия, будет практически невозможно».

Члены ООН собираются провести на следующей неделе встречу, на которой планируется обсудить вопросы, связанные с запретом летального автономного вооружения, способного убивать без участия человека. К слову, это будет уже далеко не первая подобная встреча, однако участники обсуждения пока так и не пришли к какому-либо соглашению. Одна из проблем, стоящая на пути принятия каких-то конкретных решений, заключается в том, что некоторые страны как раз совсем не против ведения разработок подобных технологий, поскольку те смогут повысить их военный потенциал. Камнем преткновения становятся и частные компании, которые активно противятся контролю со стороны правительств за разработками их собственных моделей систем искусственного интеллекта.

Казалось бы, многие согласны с тем, что роботы-убийцы – это плохо. Однако принять каких-то конкретных решений в отношении того, что же делать с их разработкой, пока не получается. Вполне возможно, что разработка новых систем вооружения, которой планирует заняться KAIST, заставит больше сторон принять участие в необходимом обсуждении проблемы.

Многие ученые призывают к созданию рекомендательных инструкций, регулирующих вопросы разработки и развертывания ИИ-систем. Тем не менее высока вероятность, что даже при наличии оных будет весьма сложно следить за тем, чтобы каждая сторона их придерживалась.

«Мы зациклены на гонке вооружений, которой никому не хочется. Действия KAIST только ускорят эту гонку вооружений. Мы не можем терпеть это. Я надеюсь, что этот бойкот повысит актуальность в необходимости обсуждения данного вопроса в ООН в понедельник», — прокомментировал профессор по искусственному интеллекту австралийского Университета Нового Южного Уэльса Тоби Уолш, также подписавший письмо.

«Это ясное обращение к сообществу, занимающемуся развитием технологий искусственного интеллекта и робототехники — не поддерживать разработки автономных видов вооружения. Любые другие институты, планирующие открыть подобные лаборатории, должны подумать дважды».

Новости, статьи и анонсы публикаций

Чат с читателямиСвободное общение и обсуждение материалов