Как обмануть алгоритм искусственного интеллекта и чем это чревато

За окном 2022 год. Вы едете на самоуправляемой машине, как обычно, по городу. Автомобиль подходит к знаку «стоп», мимо которого проезжал много раз, но в этот раз не останавливается перед ним. Для вас этот знак «стоп» похож на другие. Но для автомобиля он совершенно другой. Несколькими минутами ранее, никого не предупредив, злоумышленник наклеил на знак маленькую табличку, незаметную для человеческого глаза, но которую не может не заметить технология. То есть малюсенькая наклейка на знаке превратила знак «стоп» в нечто, совершенно отличное от знака «стоп».

Можно ли считать это обманом ИИ?

Все это может показаться невероятным. Но растущая область исследований доказывает, что искусственный интеллект может быть обманут примерно так, если увидит какую-нибудь крошечную деталь, совершенно незаметную для людей. По мере того как алгоритмы машинного обучения все чаще появляются на наших дорогах, наши финансы, наша система здравоохранения, компьютерные ученые надеются узнать больше о том, как защитить их от подобных атак — прежде чем кто-то попытается одурачить их по-настоящему.

«Это вызывает растущую озабоченность в области машинного обучения и сообщества ИИ, особенно потому что эти алгоритмы используются все больше и больше», говорит Дэниел Лоуд, доцент кафедры компьютерных и информационных наук в Университете Орегона. «Если спам проходит или блокируется несколько писем, это еще не конец света. Но если вы полагаетесь на систему видения в самоуправляемой машине, которая говорит автомобилю, как ехать, ни во что не врезаясь, ставки будут намного выше».

Независимо от того, сломается машина или будет взломана, пострадают алгоритмы машинного обучения, которые «видят» мир. И вот для машины панда начинает выглядеть как гиббон, а школьный автобус — как страус.

В одном эксперименте ученые из Франции и Швейцарии показали, как такие возмущения могут заставить компьютер ошибочно принять белку за серую лису, а кофейник за попугая.

Как обмануть искусственный интеллект

Как это возможно? Подумайте о том, как ребенок учится распознавать цифры. Разглядывая символы один за другим, ребенок начинает подмечать некоторые общие характеристики: одни выше и стройнее, шестерки и девятки содержат одну большую петлю, а восьмерки — две, и так далее. После того как они увидят достаточно примеров, они могут быстро распознавать новые цифры в виде четверок, восьмерок или троек — даже если благодаря шрифту или почерку они не будут выглядеть точно так же, как любые другие четверки, восьмерки или тройки, которые они когда-либо раньше видели.

Алгоритмы машинного обучения учатся читать мир через несколько похожий процесс. Ученые скармливают компьютеру сотни или тысячи (обычно помеченных) примеров того, что они хотели бы обнаружить на компьютере. Когда машина просеивает данные — это число, это нет, это число, это нет — она начинает подмечать особенности, которые приводят к ответу. Вскоре она может посмотреть на картинку и сказать: «Это пять!» с высокой точностью.

Таким образом, как человеческие дети, так и компьютеры могут научиться распознавать огромное количество объектов — от цифр до кошек, от лодок до отдельных человеческих лиц.

Но, в отличие от дитяти человека, компьютер не обращает внимания на детали высокого уровня — вроде пушистых ушей кошек или отличительной угловатой формы четверки. Он не видит цельную картинку.

Вместо этого он смотрит на отдельные пиксели изображения — и на самый быстрый способ разделить объекты. Если подавляющее число единиц будет иметь черный пиксель в определенной точке и несколько белых пикселей в других точках, машина очень быстро научится их определять по нескольким пикселям.

Хотели бы вы, чтобы ИИ распознавал ваши эмоции?

Теперь вернемся к знаку «стоп». Незаметно поправив пиксели изображения — эксперты называют такое вмешательство «пертурбациями» — можно обмануть компьютер и заставить думать, что знака «стоп», в сущности, и нет.

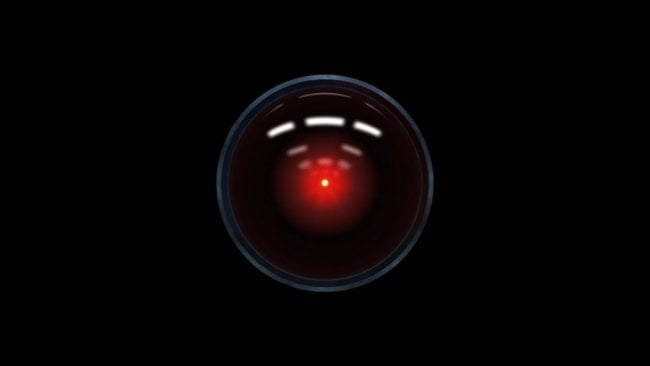

Аналогичные исследования, проведенные в Лаборатории эволюционного искусственного интеллекта в Университете Вайоминга и Корнеллского университета, произвели довольно много оптических иллюзий для искусственного интеллекта. Эти психоделические образы абстрактных узоров и цветов ни на что не похожи для людей, но быстро распознаются компьютером в виде змей или винтовок. Это говорит о том, как ИИ может смотреть на что-то и не видеть объект, либо видеть вместо него что-то другое.

Эта слабость распространена во всех типах алгоритмов машинного обучения. «Можно было бы ожидать, что каждый алгоритм имеет брешь в броне», говорит Евгений Воробейчик, доцент кафедры информатики и вычислительной техники в Университете Вандербильта. «Мы живем в очень сложном многомерном мире, и алгоритмы по своей природе затрагивают лишь небольшую его часть».

Воробейчик «крайне уверен», что, если эти уязвимости существуют, кто-то выяснит, как ими воспользоваться. Вероятно, кто-то уже это сделал.

Рассмотрим спам-фильтры, автоматизированные программы, которые отсеивают любые неуклюжие электронные письма. Спамеры могут попытаться обойти этот заслон, изменив написание слов (вместо виагры — ви@гра) или добавив список «хороших слов», которые обычно встречаются в нормальных письмах: вроде «ага», «меня», «рад». Между тем спамеры могут попытаться убрать слова, которые часто появляются в спаме, например, «мобильный» или «выигрыш».

Чем опасен искусственный интеллект

До чего могут дойти мошенники в один прекрасный день? Самоуправляемый автомобиль, обманутый наклейкой на знак «стоп», является классическим сценарием, который был придуман экспертами в этой области. Дополнительные данные могут помочь порнографии проскочить через безопасные фильтры. Другие могут попытаться увеличить количество чеков. Хакеры могут подправить код вредоносного программного обеспечения, чтобы ускользнуть от органов правопорядка.

Нарушители могут понять, как создавать пропускающие данные, если заполучат копию алгоритма машинного обучения, которое хотят обмануть. Но чтобы пробраться сквозь алгоритм, это и не обязательно. Можно просто сломать его грубой силой, набрасывая на него немного разные версии электронной почты или изображений, пока они не пройдут. Со временем это можно будет даже использовать для совершенно новой модели, которая будет знать, что ищут хорошие ребята, и какие производить данные, чтобы их обмануть.

«Люди манипулируют системами машинного обучения с тех пор, как они были представлены впервые», говорит Патрик Макдэниел, профессор компьютерных наук и инженерии в Пенсильванском университете. «Если люди используют эти методы, мы можем даже об этом не знать».

Этими же методами могут воспользоваться не только мошенники — люди могут скрываться от рентгеновских глаз современных технологий.

«Если вы какой-нибудь политический диссидент при репрессивном режиме и хотите проводить мероприятия без ведома спецслужб, вам может понадобиться избегание автоматических методов наблюдения на основе машинного обучения», говорит Лоуд.

В одном из проектов, опубликованных в октябре, исследователи из Университета Карнеги — Меллона создали пару очков, которые могут тонко ввести в заблуждение систему распознавания лиц, заставив компьютер ошибочно принимать актрису Риз Уизерспун за Рассела Кроу. Это звучит смешно, но такая технология может пригодиться кому-нибудь, кто отчаянно пытается избежать цензуры со стороны власть имущих.

Если вам интересны новости науки и технологий, подпишитесь на нас в Google Новостях и Яндекс.Дзен, чтобы не пропускать новые материалы!

Как создать идеальный ИИ

Что же со всем этим делать? «Единственный способ полностью избежать этого — создать идеальную модель, которая будет всегда правильной», говорит Лоуд. Даже если мы смогли бы создать искусственный интеллект, который превзошел бы людей во всех отношениях, мир все еще может подсунуть свинью в неожиданном месте.

Алгоритмы машинного обучения обычно оценивают по их точности. Программа, которая распознает стулья в 99% случаев, будет явно лучше, чем та, которая распознает 6 стульев из 10. Но некоторые эксперты предлагают другой способ оценки возможности алгоритма справиться с атакой: чем жестче, тем лучше.

Может ли мыслить существо, созданное человеком?

Другое решение может заключаться в том, чтобы эксперты могли задавать программам определенный темп. Создайте свои собственные примеры атак в лаборатории, исходя из возможностей преступников на ваш взгляд, а затем покажите их алгоритму машинного обучения. Это может помочь ему стать более устойчивым с течением времени — при условии, конечно, что тестовые атаки будут соответствовать типу, который будет проверен в реальном мире.

«Системы машинного обучения — инструмент для осмысления. Мы должны быть разумными и рациональными в отношении того, что мы им даем и что они нам говорят», считает Макдэниел. «Мы не должны относиться к ним как к совершенным оракулам истины».

Новости, статьи и анонсы публикаций

Чат с читателямиСвободное общение и обсуждение материалов