Роботы вскоре обретут инстинкт самосохранения

Одним из отличительных свойств живых организмов являются заложенные в нас природой программы поведения, которые мы называем инстинктами. И не последним из них, позволившим человеку взойти на вершину эволюционной лестницы, является инстинкт самосохранения. Благодаря ему мы способны ограждать себя от возможной опасности: будь то осторожность при переходе проезжей части или отказ от ночных прогулок в неблагоприятных районах. Но совсем скоро роботы тоже могут научиться ограждать себя от опасности.

Роботизированные механизмы действуют согласно заложенной в них программе и не могут отступать от нее ни на шаг, даже в том случае, если робот будет на полном ходу нестись в сторону пропасти. Специалисты из DARPA разработали специальный алгоритм, который позволит самоуправляемым механизмам предсказывать возможную опасность и тем самым спасать себя от поломок или даже уничтожения.

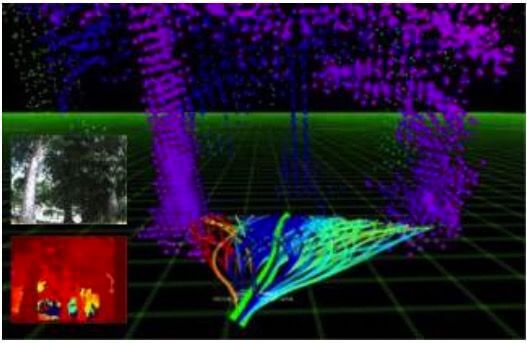

Алгоритм DARPA в действии. Летающий дрон просчитывает траекторию полета. Красные линии указывают опасные и потенциально опасные маршруты

Во время испытаний алгоритма самосохранения DARPA указали дрону начальную и конечную точки маршрута, который проходил через лесополосу и составлял 1 километр. Результаты нескольких запусков с разными точками начала и конца маршрута оказались положительными.

Стоит упомянуть, что разработка DARPA далеко не уникальна. Исследовательский отдел компании Microsoft работает над подобной системой уже несколько лет. Испытания планируются в недалеком будущем, но алгоритм поведения Microsoft выглядит более интересным. В функциональность системы входит не только возможность анализировать ситуацию, но и запоминать полученную информацию, чтобы избегать неприятных ситуаций в будущем. Более того, роботы будут способны делиться друг с другом картами местности с указанием всех опасных маршрутов.

Несмотря на то, что данный алгоритм еще больше приближает роботизированные механизмы к подобию того, что нам рисуют фантастические фильмы о будущем, бить тревогу пока рано, ведь это всего лишь набор команд, по своей сути мало чем отличающийся от обычных программ, закладываемых в память машин. Пока машины не обретут чувство самосознания, о наступлении мрачного будущего можно не беспокоиться. Хотя кто знает, какие алгоритмы разрабатываются сейчас в рамках секретных проектов….

Новости, статьи и анонсы публикаций

Чат с читателямиСвободное общение и обсуждение материалов