Искусственный интеллект. Все, что вы хотели знать

Причина, по которой эта (и другие) статья появилась на свет, проста: возможно, искусственный интеллект — не просто важная тема для обсуждения, а самая важная в контексте будущего. Все, кто хоть немного проникает в суть потенциала искусственного интеллекта, признают, что оставлять без внимания эту тему нельзя. Некоторые — и среди них Элон Маск, Стивен Хокинг, Билл Гейтс, не самые глупые люди нашей планеты — считают, что искусственный интеллект представляет экзистенциальную угрозу для человечества, сопоставимую по масштабам с полным вымиранием нас как вида. Что ж, усаживайтесь поудобнее и расставляйте для себя все точки над i.

Эксперименты с искусственным интеллектом привели к удивительным открытиям

«Мы стоим на пороге изменений, сравнимых с зарождением человеческой жизни на Земле» (Вернор Виндж).

Что значит стоять на пороге таких изменений?

Содержание

- 1 Часть первая: путь к сверхинтеллекту

- 1.1 Будущее ИИ

- 1.2 Что такое ИИ (искусственный интеллект)?

- 1.3 Человек и искусственный интеллект

- 1.4 Путь от УИИ к ОИИ: почему так сложно?

- 1.5 Первый шаг к созданию ОИИ: увеличение вычислительной мощи

- 1.6 Второй шаг к созданию ОИИ: дать ему разум

- 1.7 Все это может случиться очень скоро

- 1.8 Дорога от ОИИ к ИСИ

- 1.9 Взрыв интеллекта

- 2 Часть вторая: вымирание или бессмертие?

- 2.1 Чем отличается сверхинтеллект от качественного интеллекта?

- 2.2 Где мы окажемся после этого?

- 2.3 Что получается, когда мы складываем все эти мнения вместе?

- 2.4 Кто или что будет контролировать эту силу и какой будет его мотивация?

- 2.5 Почему будущее может быть нашей величайшей мечтой?

- 2.6 Несколько слов о нанотехнологиях

- 2.7 Что ИИ мог бы сделать для нас?

- 3 Часть третья: почему искусственный интеллект может стать нашим последним изобретением?

Часть первая: путь к сверхинтеллекту

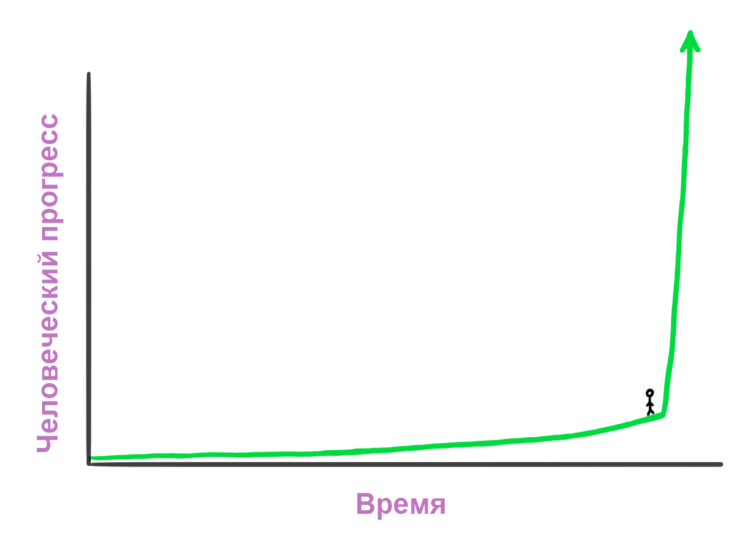

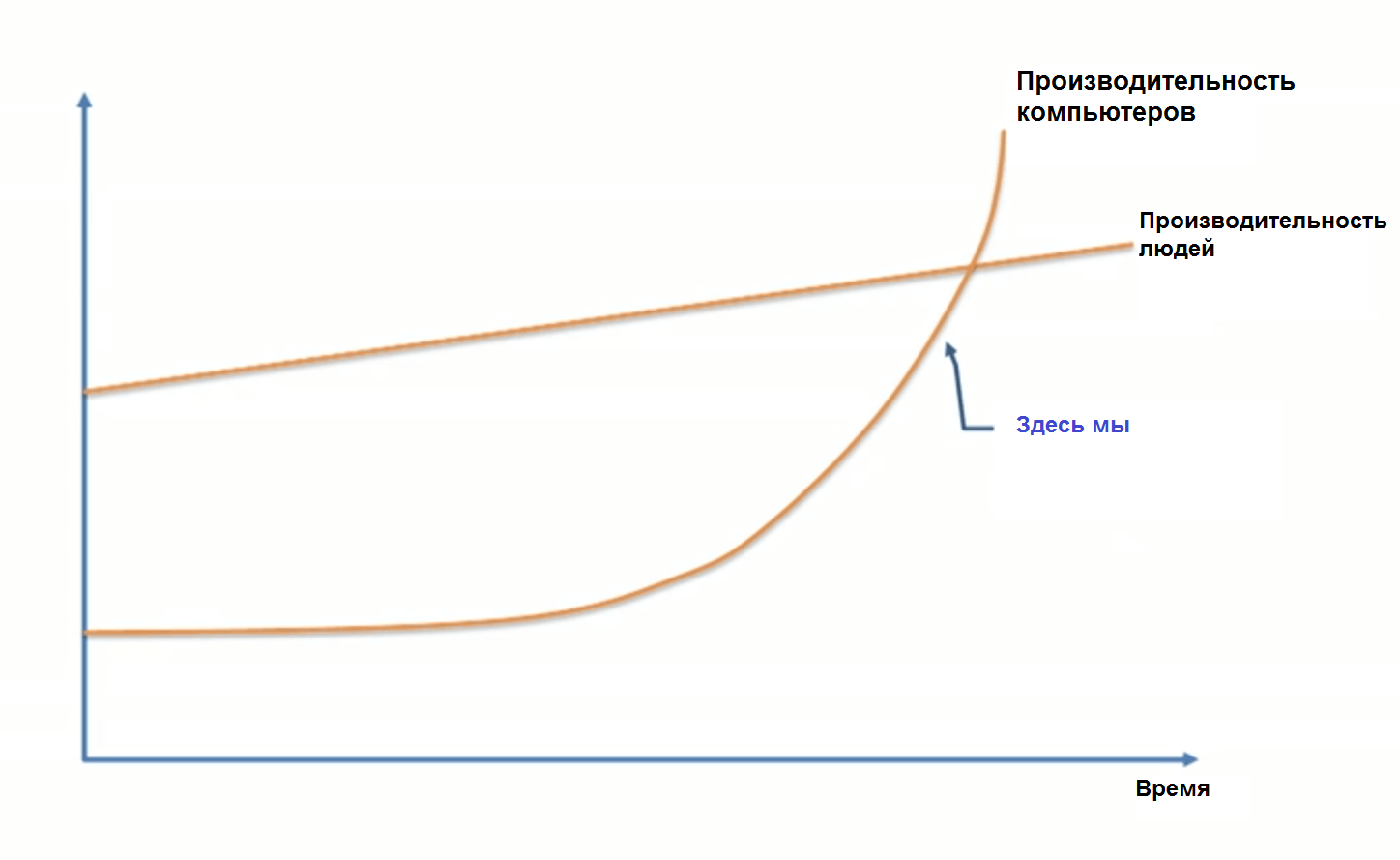

Вроде бы ничего особенного. Но вы должны помнить, что находиться на графике в таком месте означает то, что вы не знаете, что находится справа от вас.

Вы должны ощущать себя примерно так

Ощущения вполне нормальные, полет проходит успешно.

Будущее ИИ

Представьте, что машина времени перенесла вас в 1750 год — во времена, когда мир испытывал постоянные перебои с поставками электричества, связь между городами подразумевала выстрелы из пушки, а весь транспорт работал на сене. Допустим, вы попадаете туда, забираете кого-нибудь и приводите в 2015 год, показать, как оно тут все. Мы не в состоянии понять, каково ему было бы увидеть все эти блестящие капсулы, летящие по дорогам; поговорить с людьми по ту сторону океана; посмотреть на спортивные игры за тысячу километров от него; услышать музыкальное выступление, записанное 50 лет назад; поиграть с волшебным прямоугольником, который может сделать снимок или запечатлеть живой момент; построить карту с паранормальной голубой точкой, обозначающей его местоположение; смотреть на чье-то лицо и общаться с ним за много километров и так далее. Все это — необъяснимое волшебство для почти трехсотлетних людей. Не говоря уже об Интернете, Международной космической станции, Большом адронном коллайдере, ядерном оружии и общей теории относительности.

Такой опыт для него не будет удивительным или шокирующим — эти слова не передают всей сути мысленного коллапса. Наш путешественник вообще может умереть.

Но есть интересный момент. Если он вернется в 1750 год и ему станет завидно, что мы захотели взглянуть на его реакцию на 2015 год, он может захватить с собой машину времени и попробовать проделать то же самое, скажем, с 1500 годом. Прилетит туда, найдет человека, заберет в 1750 год и все покажет. Парень из 1500 года будет шокирован безмерно — но вряд ли умрет. Хотя он, конечно, будет удивлен, разница между 1500 и 1750 годом куда меньше, чем между 1750 и 2015. Человек из 1500 года удивится некоторым моментам из физики, поразится тому, какой стала Европа под жесткой пятой империализма, нарисует в голове новую карту мира. Но повседневная жизнь 1750 года — транспорт, связь и т. п. — вряд ли удивит его до смерти.

Нет, чтобы парень из 1750 года повеселился так же, как мы с ним, он должен отправиться куда дальше — возможно, год так в 12 000 до н. э., еще до того, как первая сельскохозяйственная революция позволила зародиться первым городам и понятию цивилизации. Если бы кто-либо из мира охотников-собирателей, со времен, когда люди в большей степени были еще очередным животным видом, увидел огромные человеческие империи 1750 года с их высокими церквями, судами, пересекающими океаны, их понятие быть «внутри» здания, все эти знания — он бы умер, скорее всего.

И тогда, после смерти, он бы позавидовал и захотел сделать то же самое. Вернулся бы на 12 000 лет назад, в 24 000 год до н. э., забрал бы человека и притащил его в свое время. И новый путешественник сказал бы ему: «Ну такое, хорошо, спасибо». Потому что в этом случае человеку из 12 000 год до н. э. нужно было бы вернуться на 100 000 лет назад и показать местным аборигенам огонь и язык в первый раз.

Если нам нужно перевезти кого-то в будущее, чтобы тот был до смерти удивлен, прогресс должен пройти определенное расстояние. Должна быть достигнута Точка Смертельного Прогресса (ТСП). То есть, если во времена охотников-собирателей ТСП занимала 100 000 лет, следующая остановка состоялась уже в 12 000 году до н. э. За ней прогресс шел уже быстрее и кардинально преобразил мир к 1750 году (ориентировочно). Потом понадобилось пару сотен лет, и вот мы здесь.

Эту картину — когда человеческий прогресс движется быстрее по мере течения времени — футуролог Рэй Курцвейл называет законом ускоряющейся отдачи человеческой истории. Это происходит, потому что у более развитых обществ есть возможность двигать прогресс более быстрыми темпами, нежели у менее развитых обществ. Люди 19 века знали больше, чем люди 15 века, поэтому неудивительно, что прогресс в 19 веке шел более стремительными темпами, нежели в 15 веке, и так далее.

На меньших масштабах это тоже работает. Фильм «Назад в будущее» вышел в 1985 году, и «прошлое» было в 1955 году. В фильме, когда Майкл Джей Фокс вернулся в 1955 год, его застали врасплох новизна телевизоров, цены на содовую, отсутствие любви к гитарному звуку и вариации в сленге. Это был другой мир, безусловно, но если бы фильм снимали сегодня, а прошлое было в 1985 году, разница была бы куда более глобальна. Марти Макфлай, попавший в прошлое из времени персональных компьютеров, Интернета, мобильных телефонов, был бы гораздо более неуместным, чем Марти, отправившийся в 1955 год из 1985.

Все это благодаря закону ускоряющейся отдачи. Средняя скорость развития прогресса между 1985 и 2015 годами была выше, чем скорость с 1955 по 1985 годы — потому что в первом случае мир был более развитым, он был насыщен достижениями последних 30 лет.

Таким образом, чем больше достижений, тем быстрее происходят изменения. Но разве это не должно оставлять нам определенные намеки на будущее?

Курцвейл предполагает, что прогресс всего 20 века мог бы быть пройден всего за 20 лет при уровне развития 2000 года — то есть в 2000 году скорость прогресса была в пять раз выше, чем средняя скорость прогресса 20 века. Также он считает, что прогресс всего 20 века был эквивалентен прогрессу периода с 2000 по 2014 год, и прогресс еще одного 20 века будет эквивалентен периоду до 2021 года — то есть всего за семь лет. Спустя несколько десятков лет весь прогресс 20 века будет проходиться по несколько раз в год, а дальше — всего за месяц. В конечном итоге закон ускоряющейся отдачи доведет нас до того, что за весь 21 век прогресс будет в 1000 раз превышать прогресс 20 века.

Если Курцвейл и его сторонники правы, 2030 год удивит нас так же, как парня из 1750 года удивил бы наш 2015 — то есть следующая ТСП займет всего пару десятков лет — а мир 2050 года будет так сильно отличаться от современного, что мы едва ли его узнаем. И это не фантастика. Так полагает множество ученых, которые умнее и образованнее нас с вами. И если вы взглянете в историю, то поймете, что это предсказание вытекает из чистой логики.

Почему же, когда мы сталкиваемся с заявлениями вроде «мир через 35 лет изменится до неузнаваемости», мы скептически пожимаем плечами? Есть три причины нашего скепсиса относительно прогнозов будущего:

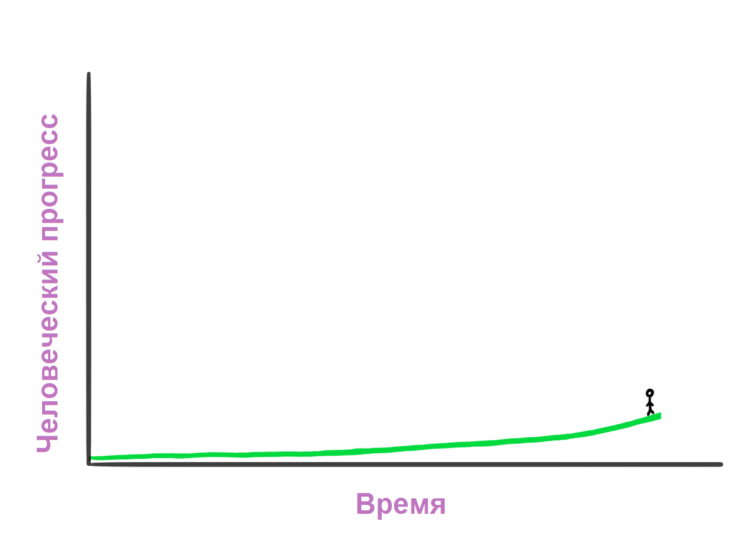

1. Когда дело доходит до истории, мы думаем прямыми цепочками. Пытаясь представить прогресс следующих 30 лет, мы смотрим на прогресс предыдущих 30 как на индикатор того, сколько всего, по всей вероятности, произойдет. Когда мы думаем о том, как изменится наш мир в 21 веке, мы берем прогресс 20 века и добавляем его к 2000 году. Такую же ошибку совершает наш парень из 1750 года, когда достает кого-то из 1500 года и пытается его удивить. Мы интуитивно думаем линейным образом, хотя должны бы экспоненциальным. По существу, футуролог должен пытаться предугадать прогресс следующих 30 лет, не глядя на предыдущие 30, а судя по текущему уровню прогресса. Тогда прогноз будет точнее, но все равно мимо ворот.

Чтобы думать о будущем корректно, вам нужно видеть движение вещей в куда более быстром темпе, чем они движутся сейчас.

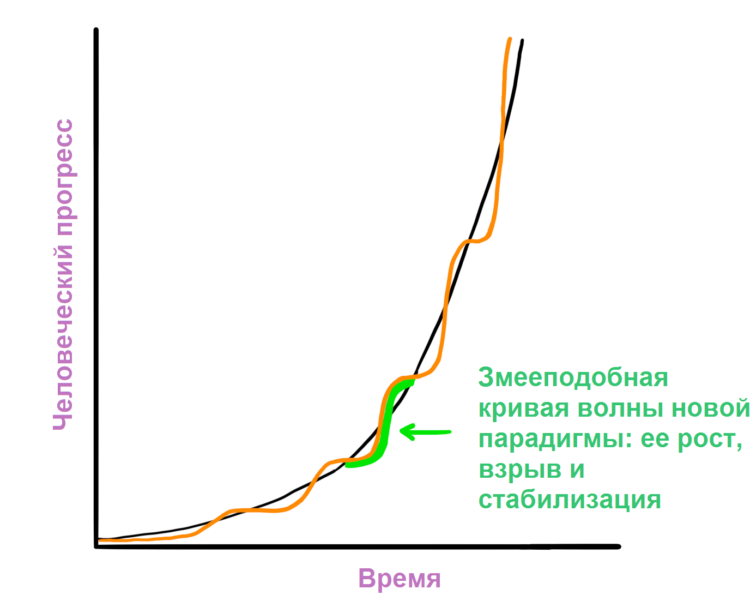

2. Траектория недавней истории зачастую выглядит искаженно. Во-первых, даже крутая экспоненциальная кривая кажется линейной, когда вы видите небольшие ее части. Во-вторых, экспоненциальный рост не всегда гладкий и однородный. Курцвейл считает, что прогресс движется змееподобными кривыми.

Такая кривая проходит через три фазы: 1) медленный рост (ранняя фаза экспоненциального роста); 2) быстрый рост (взрывная, поздняя фаза экспоненциального роста); 3) стабилизация в виде конкретной парадигмы.

Если вы взглянете на последнюю историю, часть S-кривой, в которой вы в данный момент находитесь, может скрывать от вашего восприятия скорость прогресса. Часть времени между 1995 и 2007 годами ушла на взрывное развитие Интернета, представление Microsoft, Google и Facebook публике, рождению социальных сетей и развитию сотовых телефонов, а затем и смартфонов. Это была вторая фаза нашей кривой. Но период с 2008 по 2015 год был менее прорывным, по крайней мере на технологическом фронте. Те, кто думают о будущем сегодня, могут взять последние пару лет для оценки общего темпа прогресса, но они не видят большей картины. На деле же новая и мощная фаза 2 может назревать уже сейчас.

3. Наш собственный опыт делает нас ворчливыми стариками, когда речь заходит о будущем. Мы основываем свои идеи о мире на собственном опыте, и этот опыт установил темпы роста в недавнем прошлом для нас как «само собой разумеющееся». Также и наше воображение ограничено, поскольку использует наш опыт для прогнозирования — но чаще всего у нас просто нет инструментов, которые позволяют точно предположить будущее. Когда мы слышим прогнозы на будущее, которые расходятся с нашим повседневным восприятием работы вещей, мы инстинктивно считаем их наивными. Если бы я сказал вам, что вы доживете до 150 или 250 лет, а может быть, и вовсе не умрете, вы инстинктивно подумаете, что «это глупо, я знаю из истории, что за это время умирали все». Так и есть: никто не доживал до таких лет. Но и ни один самолет не летал до изобретения самолетов.

Таким образом, хотя скепсис кажется вам обоснованным, чаще всего он ошибочен. Нам стоит принять, что если мы вооружаемся чистой логикой и ждем привычных исторических зигзагов, мы должны признать, что очень, очень и очень многое должно измениться в ближайшие десятилетия; намного больше, чем можно предположить интуитивно. Логика также подсказывает, что если самый продвинутый вид на планете продолжает делать гигантские скачки вперед, быстрее и быстрее, в определенный момент скачок будет настолько серьезным, что он кардинально изменит жизнь, какой мы ее знаем. Нечто подобное случилось в процессе эволюции, когда человек стал настолько умен, что полностью изменил жизнь любого другого вида на планете Земля. И если вы потратите немного времени на чтение того, что происходит сейчас в науке и технике, вы, возможно, начнете видеть определенные подсказки о том, каким будет следующий гигантский скачок.

Что такое ИИ (искусственный интеллект)?

Как и многие на этой планете, вы привыкли считать искусственный интеллект глупой идеей научной фантастики. Но за последнее время очень много серьезных людей проявило обеспокоенность этой глупой идеей. Что не так?

Есть три причины, которые приводят к путанице вокруг термина ИИ:

- Мы ассоциируем ИИ с фильмами. «Звездные войны». «Терминатор». «Космическая Одиссея 2001 года». Но как и роботы, ИИ в этих фильмах — вымысел. Таким образом, голливудские ленты разбавляют уровень нашего восприятия, ИИ становится привычным, родным и, безусловно, злобным.

- Это широкое поле для применения. Оно начинается с калькулятора в вашем телефоне и разработки самоуправляемых автомобилей и доходит до чего-то далекого в будущем, что кардинально изменит мир. ИИ обозначает все эти вещи, и это сбивает с толку.

- Мы используем ИИ каждый день, но зачастую даже не отдаем себе в этом отчета. Как говорил Джон Маккарти, изобретатель термина «искусственный интеллект» в 1956 году, «как только он заработал, никто больше не называет его ИИ». ИИ стал больше как мифическое предсказание о будущем, нежели что-то реальное. В то же время есть в этом названии и привкус чего-то из прошлого, что никогда не стало реальностью. Рэй Курцвейл говорит, что он слышит, как люди ассоциируют ИИ с фактами из 80-х годов, что можно сравнить с «утверждением, что интернет умер вместе с доткомами в начале 2000-х».

Давайте проясним. Во-первых, перестаньте думать о роботах. Робот, который является контейнером для ИИ, иногда имитирует человеческую форму, иногда нет, но сам ИИ — это компьютер внутри робота. ИИ — это мозг, а робот — тело, если у него вообще есть это тело. К примеру, программное обеспечение и данные Siri — это искусственный интеллект, женский голос — персонификация этого ИИ, и никаких роботов в этой системе нет.

Во-вторых, вы наверняка слышали термин «сингулярность» или «технологическая сингулярность». Этот термин используется в математике для описания необычной ситуации, когда обычные правила больше не работают. В физике он используется для описания бесконечно малой и плотной точки черной дыры или изначальной точки Большого Взрыва. Опять же, законы физики в ней не работают. В 1993 году Вернор Виндж написал знаменитое эссе, в котором применил этот термин к моменту в будущем, когда интеллект наших технологий превзойдет наш собственный — и в этот момент жизнь, какой мы ее знаем, изменится навсегда, а обычные правила ее существования больше не будут работать. Рэй Курцвейл в дальнейшем уточнил этот термин, указав, что сингулярность будет достигнута, когда закон ускоряющейся отдачи достигнет экстремальной точки, когда технологический прогресс будет двигаться так быстро, что мы перестанем замечать его достижения, почти бесконечно быстро. Тогда мы будем жить в совершенно новом мире. Однако многие эксперты перестали использовать этот термин, поэтому давайте и мы не будем часто к нему обращаться.

Наконец, хотя есть много типов или форм ИИ, которые вытекают из широкого понятия ИИ, основные категории его зависят от калибра. Есть три основных категории:

- Узконаправленный (слабый) искусственный интеллект (УИИ). УИИ специализируется в одной области. Среди таких ИИ есть те, кто может обыграть чемпиона мира по шахматам, но на этом все. Есть такой, который может предложить лучший способ хранения данных на жестком диске, и все.

- Общий (сильный) искусственный интеллект. Иногда также называют ИИ человеческого уровня. ОИИ относят к компьютеру, который умен, как человек — машина, которая способна выполнять любое интеллектуальное действие, присущее человеку. Создать ОИИ намного сложнее, чем УИИ, и мы пока до этого не дошли. Профессор Линда Готтфредсон описывает интеллект как «в общем смысле психический потенциал, который, наряду с другими вещами, включает способность рассуждать, планировать, решать проблемы, мыслить абстрактно, понимать сложные идеи, быстро учиться и извлекать опыт». ОИИ должен уметь делать все это так же просто, как делаете вы.

- Искусственный сверхинтеллект (ИСИ). Оксфордский философ и теоретик ИИ Ник Бостром определяет сверхинтеллект как «интеллект, который гораздо умнее лучших человеческих умов в практически любой сфере, включая научное творчество, общую мудрость и социальные навыки». Искусственный сверхинтеллект включает в себя как компьютер, который немного умнее человека, так и тот, который в триллионы раз умнее в любом направлении. ИСИ и есть причина того, что растет интерес к ИИ, а также того, что в таких обсуждениях часто появляются слова «вымирание» и «бессмертие».

В настоящее время люди уже покорили самую первую ступень калибра ИИ — УИИ — во многих смыслах. Революция ИИ — это путь от УИИ через ОИИ к ИСИ. Этот путь мы можем не пережить, но он, определенно, изменит все.

Давайте внимательно разберем, как видят этот путь ведущие мыслители в этой области и почему эта революция может произойти быстрее, чем вы могли бы подумать.

Человек и искусственный интеллект

Узконаправленный искусственный интеллект — это машинный интеллект, который равен или превышает человеческий интеллект или эффективность в выполнении определенной задачи.

Несколько примеров:

- Автомобили битком набиты системами УИИ, от компьютеров, которые определяют, когда должна заработать антиблокировочная тормозная система, до компьютера, который определяет параметры системы впрыска топлива. Самоуправляемые автомобили Google, которые в настоящее время проходят испытания, будут содержать надежные системы УИИ, которые будут воспринимать и реагировать на мир вокруг себя.

- Ваш телефон — маленькая фабрика УИИ. Когда вы используете приложение карт, получаете рекомендации по скачиванию приложений или музыки, проверяете погоду на завтра, говорите с Siri или делаете что-либо еще — вы используете УИИ.

- Спам-фильтр вашей электронной почты — классический тип УИИ. Он начинает с выяснения того, как отделить спам от пригодных писем, а затем обучается в процессе обработки ваших писем и предпочтений.

- А это неловкое чувство, когда еще вчера вы искали шуруповерт или новую плазму в поисковике, а сегодня видите предложения услужливых магазинов на других сайтах? Или когда в социальной сети вам рекомендуют добавить интересных людей в друзья? Все это системы УИИ, которые работают вместе, определяя ваши предпочтения, выуживая из Интернета данные о вас, подбираясь к вам все ближе и ближе. Они анализируют поведение миллионов людей и делают выводы на основе этих анализов так, чтобы продавать услуги крупных компаний или делать их сервисы лучше.

- Google Translate — еще одна классическая система УИИ, впечатляюще хороша в определенных вещах. Распознавание голоса — тоже. Когда ваш самолет садится, терминал для него определяет не человек. Цену билета — тоже. Лучшие в мире шашки, шахматы, нарды, балды и прочие игры сегодня представлены узконаправленными искусственными интеллектами.

- Поиск Google — это один гигантский УИИ, который использует невероятно хитроумные методы для ранжирования страниц и определения результатов поисковой выдачи.

И это только в потребительском мире. Сложные системы УИИ широко используются в военных, производственных и финансовых отраслях; в медицинских системах (вспомните Watson от IBM) и так далее.

Системы УИИ в настоящем виде не представляют угрозы. В худшем случае глючный или плохо запрограммированный УИИ может привести к локальному бедствию, создать перебои в энергоснабжении, обвалить финансовые рынки и тому подобное. Но хотя УИИ не обладает полномочиями для создания экзистенциальной угрозы, мы должны видеть вещи шире — нас ждет сокрушительный ураган, предвестником которого выступают УИИ. Каждая новая инновация в сфере УИИ добавляет один блок к дорожке, ведущей к ОИИ и ИСИ. Или как хорошо заметил Аарон Саенц, УИИ нашего мира похожи на «аминокислоты первичного бульона юной Земли» — пока неживые компоненты жизни, которые однажды проснутся.

Если вам интересны новости науки и технологий, подпишитесь на нас в Google Новостях и Яндекс.Дзен, чтобы не пропускать новые материалы!

Путь от УИИ к ОИИ: почему так сложно?

Ничто так не раскрывает сложность человеческого интеллекта, как попытка создать компьютер, который будет так же умен. Строительство небоскребов, полеты в космос, секреты Большого Взрыва — все это ерунда по сравнению с тем, чтобы повторить наш собственный мозг или хотя бы просто понять его. В настоящее время мозг человека — самый сложный объект в известной Вселенной.

Возможно, вы даже не подозреваете, в чем сложность создать ОИИ (компьютер, который будет умен, как человек, в общем, а не только в одной области). Создать компьютер, который может перемножать два десятизначных числа за долю секунды — проще простого. Создать такого, который сможет взглянуть на собаку и кошку и сказать, где собака, а где кошка — невероятно сложно. Создать ИИ, который может обыграть гроссмейстера? Сделано. Теперь попробуйте заставить его прочитать абзац из книги для шестилетних детей и не только понять слова, но и их значение. Google тратит миллиарды долларов, пытаясь это сделать. Со сложными вещами — вроде вычислений, расчета стратегий финансовых рынков, перевода языка — с этим компьютер справляется с легкостью, а с простыми вещами — зрение, движение, восприятие — нет. Как выразился Дональд Кнут, «ИИ сейчас делает практически все, что требует «мышления», но не может справиться с тем, что делают люди и животные не задумываясь».

Когда вы задумаетесь о причинах этого, вы поймете, что вещи, которые кажутся нам простейшими в исполнении, только кажутся такими, потому что были оптимизированы для нас (и животных) в ходе сотен миллионов лет эволюции. Когда вы протягиваете руку к объекту, мышцы, суставы, кости ваших плеч, локтей и кистей мгновенно выполняют длинные цепочки физических операций, синхронных с тем, что вы видите, и движут вашу руку в трех измерениях. Вам это кажется простым, потому что за эти процессы отвечает идеальное программное обеспечение вашего мозга. Этот простой трюк позволяет сделать процедуру регистрации нового аккаунта с вводом криво написанного слова (капчи) простым для вас и адом для вредоносного бота. Для нашего мозга в этом нет ничего сложного: нужно просто уметь видеть.

С другой стороны, перемножение крупных чисел или игра в шахматы — новые виды активности для биологических существ, и у нас не было достаточно времени, чтобы совершенствоваться в них (не миллионы лет), поэтому компьютеру несложно нас одолеть. Просто подумайте об этом: что бы вы предпочли, создать программу, которая может перемножать большие числа, или программу, которая узнает букву Б в миллионах ее видов написаний, в самых непредсказуемых шрифтах, от руки или палкой на снегу?

Все, что мы только что обозначили, это еще верхушка айсберга, касающаяся понимания и обработки информации. Чтобы выйти на один уровень с человеком, компьютер должен понимать разницу в тонких выражениях лица, разницу между удовольствием, печалью, удовлетворением, радостью, и почему Чацкий молодец, а Молчалин — нет.

Что же делать?

Первый шаг к созданию ОИИ: увеличение вычислительной мощи

Одна из необходимых вещей, которая должна произойти, чтобы ОИИ стал возможным, это увеличение мощности компьютерного оборудования. Если система искусственного интеллекта должна быть такой же умной, как мозг, ей нужно сравняться с мозгом по сырой вычислительной мощности.

Один из способов увеличить эту способность заключается в общем числе вычислений в секунду (OPS), которое может производить мозг, и вы можете определить это число, выяснив максимальное число OPS для каждой структуры мозга и сведя их воедино.

Рэй Курцвейл пришел к выводу, что достаточно взять профессиональную оценку OPS одной структуры и ее вес относительно веса всего мозга, а затем умножить пропорционально, чтобы получить общую оценку. Звучит немного сомнительно, но он проделал это много раз с разными оценками разных областей и всегда приходил к одному и тому же числу: порядка 10^16, или 10 квадриллионов OPS.

Самый быстрый суперкомпьютер в мире, китайский «Тяньхэ-2», уже обошел это число: он способен проделывать порядка 32 квадриллиона операций в секунду. Но «Тяньхэ-2» занимает 720 квадратных метров пространства, сжирает 24 мегаватта энергии (наш мозг потребляет всего 20 ватт) и стоит 390 миллионов долларов. О коммерческом или широком применении речь не идет.

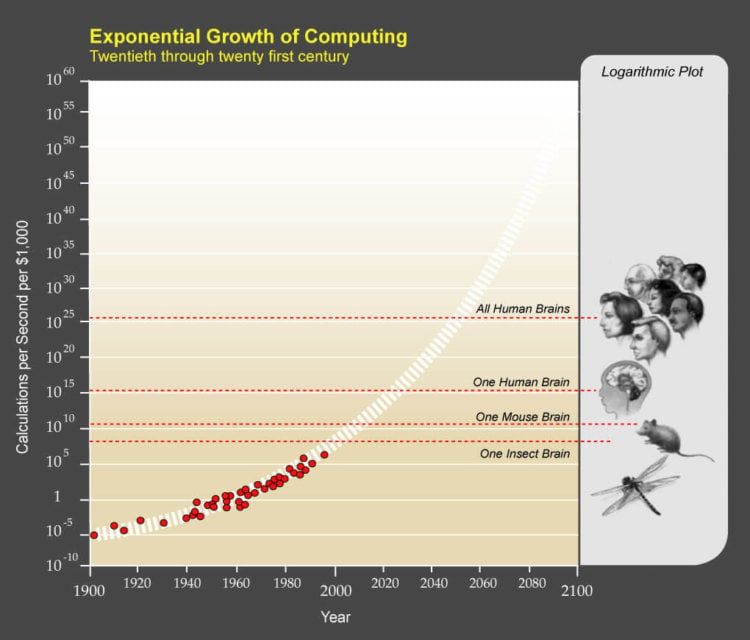

Курцвейл предполагает, что мы оцениваем состояние компьютеров по тому, как много OPS можно купить за 1000 долларов. Когда это число достигнет человеческого уровня — 10 квадриллионов OPS — ОИИ вполне может стать частью нашей жизни.

Закон Мура — исторически надежное правило, определяющее, что максимальная вычислительная мощь компьютеров умножается вдвое каждые два года — подразумевает, что развитие компьютерной техники, как и движение человека по истории, растет по экспоненте. Если соотнести это с правилом тысячи долларов Курцвейла, мы сейчас можем позволить себе 10 триллионов OPS за 1000 долларов.

Экспоненциальный рост вычислительной техники: 20-21 век. Справа логарифмическая линейка и на ней — мозг насекомого, мыши, человека и всех людей; слева — вычислений в секунду за 1000 долларов; снизу — год

Компьютеры за 1000 долларов по своим вычислительным способностям обходят мозг мыши и в тысячу раз слабее человека. Это кажется плохим показателем, пока мы не вспомним, что компьютеры были в триллион раз слабее человеческого мозга в 1985 году, в миллиард — в 1995, и в миллион — в 2005. К 2025 году мы должны получить доступный компьютер, не уступающий по вычислительной мощи нашему мозгу.

Таким образом, сырая мощь, необходимая для ОИИ, уже технически доступна. В течение 10 лет она выйдет из Китая и распространится по миру. Но одной вычислительной мощи недостаточно. И следующий вопрос: как нам обеспечить всей этой мощью интеллект человеческого уровня?

Второй шаг к созданию ОИИ: дать ему разум

Эта часть довольно сложновыполнимая. По правде говоря, никто толком не знает, как сделать машину разумной — мы до сих пор пытаемся понять, как создать разум человеческого уровня, способный отличить кошку от собаки, выделить Б, нарисованную на снегу, и проанализировать второсортный фильм. Однако есть горстка дальновидных стратегий, и в один прекрасный момент одна из них должна сработать.

Повторить мозг

Этот вариант похож на то, будто ученые сидят в одном классе с ребенком, который очень умен и хорошо отвечает на вопросы; и даже если они усердно пытаются постигать науку, они и близко не догоняют умницу-ребенка. В конечном итоге они решают: к черту, просто спишем ответы на вопросы у него. В этом есть смысл: мы не можем создать сверхсложный компьютер, так почему бы не взять за основу один из лучших прототипов вселенной: наш мозг?

Научный мир трудится в поте лица, пытаясь выяснить, как работает наш мозг и как эволюция создала такую сложную вещь. По самым оптимистичным оценкам, получится это у них только к 2030 году. Но как только мы поймем все секреты работы мозга, его эффективности и мощности, мы сможем вдохновиться его методами в создании технологий. К примеру, одной из компьютерных архитектур, которая имитирует работу мозга, является нейронная сеть. Она начинает с сети транзисторов «нейронов», соединенных друг с другом входом и выходом, и не знает ничего — как новорожденный. Система «обучается», пытаясь выполнять задания, распознавать рукописный текст и тому подобное. Связи между транзисторами укрепляются в случае правильного ответа и ослабляются в случае неверного. Спустя много циклов вопросов и ответов система образует умные нейронные переплетения, оптимизированные для выполнения определенных задач. Мозг обучается похожим образом, но в куда более сложной манере, и пока мы продолжаем изучать его, мы открываем новые невероятные способы улучшить нейронные сети.

Еще более экстремальный плагиат включает стратегию под названием «эмуляция полного мозга». Цель: нарезать настоящий мозг тонкими пластинками, отсканировать каждую из них, затем точно восстановить трехмерную модель, используя программное обеспечение, а затем воплотить ее в мощном компьютере. Тогда у нас будет компьютер, который официально сможет делать все, что может делать мозг: ему просто нужно будет обучаться и собирать информацию. Если у инженеров получится, они смогут эмулировать настоящий мозг с такой невероятной точностью, что после загрузки на компьютер настоящая личность мозга и его память останутся нетронутыми. Если мозг принадлежал Вадиму перед тем, как он умер, компьютер проснется в роли Вадима, который теперь будет ОИИ человеческого уровня, а мы, в свою очередь, займемся превращением Вадима в невероятно разумный ИСИ, чему он наверняка обрадуется.

Насколько мы далеки от полной эмуляции мозга? По правде говоря, мы только-только эмулировали мозг миллиметрового плоского червя, который содержит 302 нейрона в общей сложности. Мозг человека содержит 100 миллиардов нейронов. Если вам попытки добраться до этого числа кажутся бесполезными, вспомните об экспоненциальных темпах роста прогресса. Следующим шагом станет эмуляция мозга муравья, затем будет мышь, а там и до человека рукой подать.

Попытаться пройти по следам эволюции

Что ж, если мы решим, что ответы умного ребенка слишком сложны, чтобы их списать, мы можем попытаться пройти по его следам обучения и подготовки к экзаменам. Что мы знаем? Построить компьютер такой же мощный, как мозг, вполне возможно — эволюция нашего собственного мозга это доказала. И если мозг слишком сложен для эмуляции, мы можем попытаться эмулировать эволюцию. Дело в том, что даже если мы сможем эмулировать мозг, это может быть похоже на попытку построить самолет путем нелепого махания руками, повторяющего движения крыльев птиц. Чаще всего нам удается создать хорошие машины, используя машинно-ориентированный подход, а не точное подражание биологии.

Как имитировать эволюцию, чтобы построить ОИИ? Этот метод под названием «генетические алгоритмы» должен работать примерно так: должен быть производительный процесс и его оценка, и это будет повторяться снова и снова (точно так же биологические существа «существуют» и «оцениваются» по их способности воспроизводиться). Группа компьютеров будет выполнять задачи, а самые успешные из них будут разделять свои характеристики с другими компьютерами, «выводиться». Менее успешные будут беспощадно выбрасываться на свалку истории. Через много-много итераций этот процесс естественного отбора позволит вывести лучшие компьютеры. Сложность заключается в создании и автоматизации циклов выведения и оценки, чтобы процесс эволюции шел сам по себе.

Недостатком копирования эволюции является то, что эволюции требуются миллиарды лет, чтобы что-то сделать, а нам нужно на это всего несколько десятилетий.

Но у нас есть масса преимуществ, в отличие от эволюции. Во-первых, у нее нет дара предвидения, она работает случайно — выдает бесполезные мутации, например, — а мы можем контролировать процесс в рамках поставленных задач. Во-вторых, у эволюции нет цели, в том числе и стремления к интеллекту — иногда в окружающей среде некоторый вид выигрывает не за счет интеллекта (потому что последний потребляет больше энергии). Мы же, с другой стороны, можем нацелиться на увеличение интеллекта. В-третьих, чтобы выбрать интеллект, эволюции необходимо произвести ряд сторонних улучшений — вроде перераспределения потребления энергии клетками, — мы же можем просто убрать лишнее и использовать электричество. Вне всяких сомнений, мы будем быстрее эволюции — но опять же, непонятно, сможем ли мы ее превзойти.

Предоставить компьютеры самим себе

Это последний шанс, когда ученые совсем отчаиваются и пытаются запрограммировать программу на саморазвитие. Однако этот метод может оказаться самым перспективным из всех. Идея в том, что мы создаем компьютер, у которого будет два основных навыка: исследовать ИИ и кодировать изменения в себе — что позволит ему не только больше узнавать, но и улучшать собственную архитектуру. Мы можем обучить компьютеры быть компьютерными инженерами самим себе,чтобы они саморазвивались. И их основной задачей будет выяснить, как стать умнее. Подробнее об этом мы еще поговорим.

Все это может случиться очень скоро

Стремительное развитие аппаратного обеспечения и эксперименты с программным обеспечением текут параллельно, и ОИИ может появиться быстро и неожиданно по двум основным причинам:

1. Экспоненциальный рост идет интенсивно, и то, что кажется черепашьими шагами, может быстро перерасти в семимильные прыжки;

2. Когда дело доходит до программного обеспечения, прогресс может казаться медленным, но затем один прорыв мгновенно меняет скорость продвижения вперед (хороший пример: во времена геоцентрического мировосприятия, людям было сложно рассчитать работу вселенной, но открытие гелиоцентризма все значительно упростило). Или, когда дело доходит до компьютера, который улучшает сам себя, все может казаться чрезвычайно медленным, но иногда всего одна поправка в системе отделяет ее от тысячекратной эффективности по сравнению с человеком или прежней версией.

Дорога от ОИИ к ИСИ

В определенный момент мы обязательно получим ОИИ — общий искусственный интеллект, компьютеры с общим человеческим уровнем интеллекта. Компьютеры и люди будут жить вместе. Или не будут.

Дело в том, что ОИИ с таким же уровнем интеллекта и вычислительной мощности, что и человек, будет по-прежнему иметь значительные преимущества перед людьми.

Оборудование

Скорость. Нейроны мозга работают с частотой 200 Гц, в то время как современные микропроцессоры (которые значительно медленнее тех, что мы получим к моменту создания ОИИ) работают с частотой 2 ГГц, или в 10 миллионов раз быстрее наших нейронов. И внутренние коммуникации мозга, которые могут двигаться со скоростью 120 м/с, существенно уступают возможности компьютеров использовать оптику и скорость света.

Размер и хранение. Размер мозга ограничен размерами наших черепов, и он не может стать больше, в противном случае внутренним коммуникациям со скоростью 120 м/с потребуется слишком много времени, чтобы проходить от одной структуры к другой. Компьютеры могут расширяться до любого физического размера, задействовать больше оборудования, наращивать оперативную память, длительную память — все это выходит за рамки наших возможностей.

Надежность и долговечность. Не только память компьютера точнее человеческой. Компьютерные транзисторы точнее биологических нейронов и менее склонны к ухудшению (да и вообще, могут быть заменены или отремонтированы). Мозги людей быстрее устают, компьютеры же могут работать без остановки, 24 часа в сутки, 7 дней в неделю.

Программное обеспечение

Возможность редактирования, модернизации, более широкий спектр возможностей. В отличие от человеческого мозга, компьютерную программу можно легко исправить, обновить, провести эксперимент с ней. Модернизации могут также подвергаться зоны, в которых человеческие мозги слабы. Программное обеспечение человека, отвечающее за зрение, великолепно устроено, но с точки зрения инженерии его способности все же весьма ограничены — мы видим только в видимом спектре света.

Коллективная способность. Люди превосходят другие виды в плане грандиозного коллективного разума. Начиная с развития языка и формирования крупных сообществ, двигаясь через изобретения письма и печати и в настоящее время активизируясь с помощью таких инструментов, как интернет, коллективный разум людей является важной причиной, по которой мы можем величать себя венцом эволюции. Но компьютеры все равно будут лучше. Всемирная сеть искусственных интеллектов, работающих на одной программе, постоянно синхронизирующихся и саморазвивающихся, позволит мгновенно добавлять в базу новую информацию, где бы ее ни достали. Такая группа также сможет работать над одной целью, как одно целое, потому что компьютеры не страдают от наличия особого мнения, мотивации и личной заинтересованности, как люди.

ИИ, который, вероятнее всего, станет ОИИ посредством запрограммированного самосовершенствования, не увидит «интеллект человеческого уровня» как важную веху — эта веха важна только для нас. У него не будет никаких причин останавливаться на этом сомнительном уровне. А учитывая те преимущества, которыми будет обладать даже ОИИ человеческого уровня, довольно очевидно, что человеческий интеллект станет для него короткой вспышкой в гонке за превосходством в интеллектуальном плане.

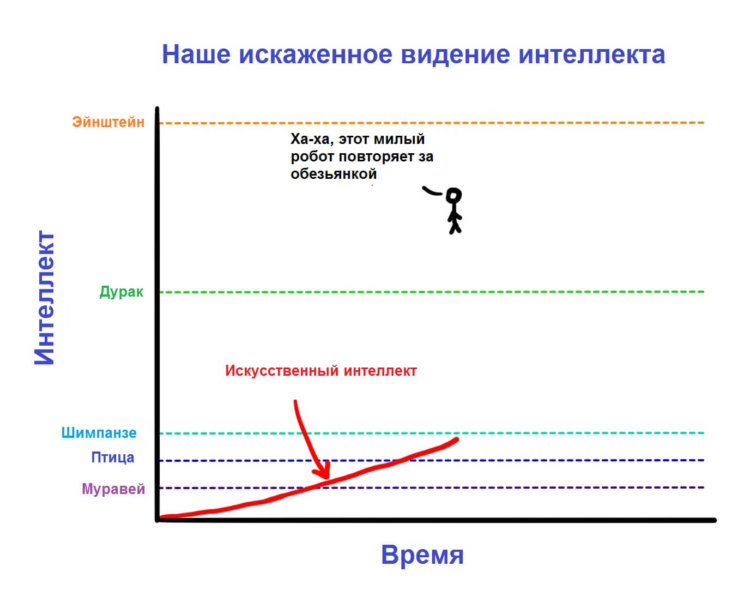

Такое развитие событий может нас весьма и весьма удивить. Дело в том, что, с нашей точки зрения, а) единственный критерий, который позволяет нам определять качество интеллекта, это интеллект животных, который по умолчанию ниже нашего; б) для нас самые умные люди ВСЕГДА умнее самых глупых. Примерно так:

То есть пока ИИ просто пытается достичь нашего уровня развития, мы видим, как он становится умнее, приближаясь к уровню животного.

Когда он доберется до первого человеческого уровня — Ник Бостром использует термин «деревенский дурачок», — мы будем в восторге: «Ух ты, он уже как дебил. Круть!». Единственное но заключается в том, что в общем спектре интеллекта людей, от деревенского дурачка до Эйнштейна, диапазон невелик — поэтому после того, как ИИ доберется до уровня дурачка и станет ОИИ, он внезапно станет умнее Эйнштейна.

И что будет дальше?

Взрыв интеллекта

Надеюсь, вам было интересно и весело, потому что именно с этого момента обсуждаемая нами тема становится ненормальной и жуткой. Нам стоит сделать паузу и напомнить себе, что каждый указанный выше и дальше факт — реальная наука и реальные прогнозы на будущее, высказанные самыми выдающимися мыслителями и учеными. Просто имейте в виду.

Итак, как мы обозначили выше, все наши современные модели по достижению ОИИ включают вариант, когда ИИ самосовершенствуется. И как только он становится ОИИ, даже системы и методы, с помощью которых он вырос, становятся достаточно умны, чтобы самосовершенствоваться — если захотят. Возникает интересное понятие: рекурсивное самосовершенствование. Работает оно примерно так.

Некая система ИИ на определенном уровне — скажем, деревенского дурачка — запрограммирована на улучшение собственного интеллекта. Развившись — скажем, до уровня Эйнштейна, — такая система начинает развиваться уже с интеллектом Эйнштейна, ей требуется меньше времени на развитие, а скачки происходят все большие. Они позволяют системе превзойти любого человека, становятся все больше и больше. По мере быстрого развития, ОИИ взмывает до небесных высот в своей интеллектуальности и становится сверхразумной системой ИСИ. Этот процесс называется взрывом интеллекта, и это ярчайший пример закона ускоряющейся отдачи.

Ученые спорят о том, как быстро ИИ достигнет уровня ОИИ — большинство считает, что ОИИ мы получим к 2040 году, всего через 25 лет, что очень и очень мало по меркам развития технологий. Продолжая логическую цепочку, нетрудно предположить, что переход от ОИИ к ИСИ тоже состоится крайне быстро. Примерно так:

«Потребовались десятки лет, прежде чем первая система ИИ достигла самого низкого уровня общего интеллекта, но это, наконец, произошло. Компьютер способен понимать мир вокруг как четырехлетний человек. Внезапно, буквально через час после достижения этой вехи, система выдает великую теорию физики, которая объединяет общую теорию относительности и квантовую механику, чего не может сделать ни один человек. Спустя полтора часа ИИ становится ИСИ, в 170 000 раз умнее любого человека».

Чтобы охарактеризовать сверхинтеллект такого масштаба, у нас даже не найдется подходящих терминов. В нашем мире «умный» означает человека с IQ 130, «глупый» — 85, но у нас нет примеров людей с IQ 12 952. Наши линейки на такое не рассчитаны.

История человечества говорит нам ясно и четко: вместе с интеллектом появляется власть и сила. Это значит, что когда мы создадим искусственный сверхинтеллект, он будет самым мощным созданием в истории жизни на Земле, и все живые существа, включая человека, будут всецело в его власти — и это может случиться уже через двадцать лет.

Если наши скудные мозги были в состоянии придумать Wi-Fi, то что-то умнее нас в сто, тысячу, миллиард раз с легкостью сможет рассчитать положение каждого атома во вселенной в любой момент времени. Все, что можно назвать магией, любая сила, которую приписывают всемогущему божеству, — все это будет в распоряжении ИСИ. Создание технологии, обращающей вспять старение, лечение любых болезней, избавление от голода и даже смерти, управление погодой — все внезапно станет возможным. Также возможен и моментальный конец всей жизни на Земле. Умнейшие люди нашей планеты сходятся во мнении, что как только в мире появится искусственный сверхинтеллект, это ознаменует появление бога на Земле. И остается важный вопрос.

Будет ли он добрым богом?

Часть вторая: вымирание или бессмертие?

Первая часть статьи началась довольно невинно. Мы обсудили узконаправленный искусственный интеллект (УИИ, который специализируется на решении одной конкретной задачи вроде определения маршрутов или игры в шахматы), в нашем мире его много. Затем проанализировали, почему так сложно вырастить из УИИ общенаправленный искусственный интеллект (ОИИ, или ИИ, который по интеллектуальным возможностям может сравниться с человеком в решении любой задачи). Мы пришли к выводу, что экспоненциальные темпы технического прогресса намекают на то, что ОИИ может появиться довольно скоро.

Как обычно, мы смотрим на экран, не веря в то, что искусственный сверхинтеллект (ИСИ, который намного умнее любого человека) может появиться уже при нашей жизни, и подбирая эмоции, которые лучше всего бы отражали наше мнение по этому вопросу.

Прежде чем мы углубимся в особенности ИСИ, давайте напомним себе, что значит для машины быть сверхразумной.

Чем отличается сверхинтеллект от качественного интеллекта?

Основное различие лежит между быстрым сверхинтеллектом и качественным сверхинтеллектом. Зачастую первое, что приходит в голову при мысли о сверхразумном компьютере, это то, что он может думать намного быстрее человека — в миллионы раз быстрее, и за пять минут постигнет то, на что человеку потребовалось бы лет десять. («Я знаю кунг-фу!»)

Звучит впечатляюще, и ИСИ действительно должен мыслить быстрее любого из людей — но основная отделяющая черта будет заключаться в качестве его интеллекта, а это совсем другое. Люди намного умнее обезьян не потому, что быстрее соображают, а потому что мозги людей содержат ряд хитроумных когнитивных модулей, которые осуществляют сложные лингвистические репрезентации, долгосрочное планирование, абстрактное мышление, на что обезьяны не способны. Если разогнать мозг обезьяны в тысячу раз, умнее нас она не станет — даже через десять лет она не сможет собрать конструктор по инструкции, на что человеку понадобилось бы пару часов максимум. Есть вещи, которым обезьяна никогда не научится, вне зависимости от того, сколько часов потратит или как быстро будет работать ее мозг.

Кроме того, обезьяна не умеет по-человечески, потому что ее мозг просто не в состоянии осознать существование других миров — обезьяна может знать, что такое человек и что такое небоскреб, но никогда не поймет, что небоскреб был построен людьми. В ее мире все принадлежит природе, и макака не только не может построить небоскреб, но и понять, что его вообще может кто-либо построить. И это результат небольшой разницы в качестве интеллекта.

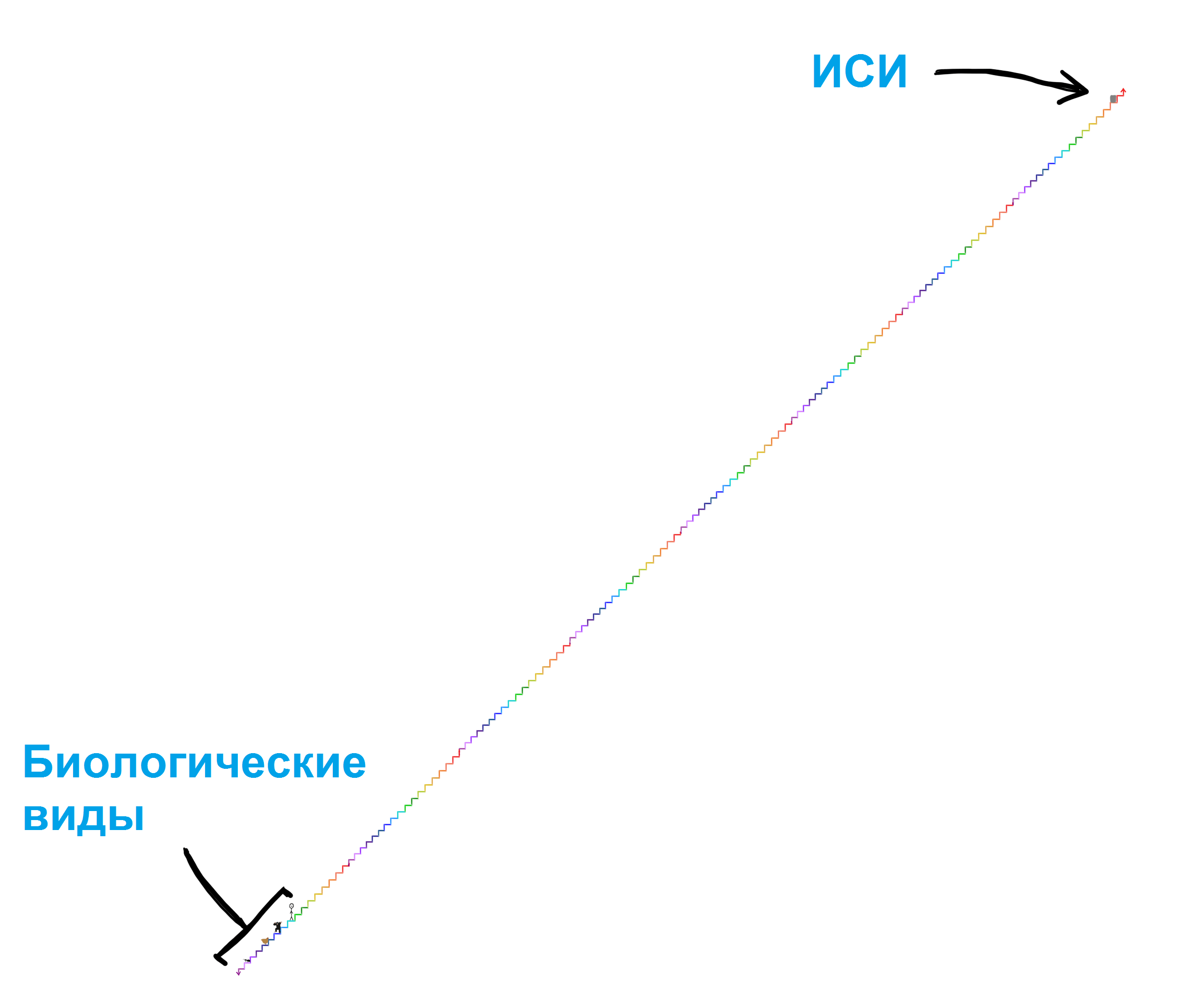

В общей схеме интеллекта, о которой мы говорим, или просто по меркам биологических существ, разница в качестве интеллекта человека и обезьяны крошечная.

Чтобы понять, насколько серьезной будет сверхразумная машина, поместите ее на две ступеньки выше, чем человек на этой лестнице. Эта машина может быть сверхразумной совсем чуть-чуть, но ее превосходство над нашими познавательными способностями будет такое же, как наше — над обезьяньими. И как шимпанзе никогда не постигнет, что небоскреб может быть построен, мы можем никогда не понять того, что поймет машина на пару ступенек выше, даже если машина попытается объяснить это нам. А ведь это всего пара ступенек. Машина поумнее увидит в нас муравьев — она будет годами учить нас простейшим с ее позиции вещам, и эти попытки будут совершенно безнадежными.

Тип сверхинтеллекта, о котором мы поговорим сегодня, лежит далеко за пределами этой лестницы. Это взрыв интеллекта — когда чем умнее становится машина, тем быстрее она может увеличивать собственный интеллект, постепенно наращивая обороты. Такой машине могут понадобиться годы, чтобы превзойти шимпанзе в интеллекте, но, возможно, пару часов, чтобы превзойти нас на пару ступенек. С этого момента машина может уже перепрыгивать через четыре ступеньки каждую секунду.

Именно поэтому нам стоит понять, что очень скоро после того, как появятся первые новости о том, что машина достигла уровня человеческого интеллекта, мы можем столкнуться с реальностью сосуществования на Земле с чем-то, что будет гораздо выше нас на этой лестнице (а может, и в миллионы раз выше)

И раз уж мы установили, что совершенно бесполезно пытаться понять мощь машины, которая всего на две ступеньки выше нас, давайте определим раз и навсегда, что нет никакого способа понять, что будет делать ИСИ и какими будут последствия этого для нас. Любой, кто заявляет о противоположном, просто не понимает, что означает сверхинтеллект.

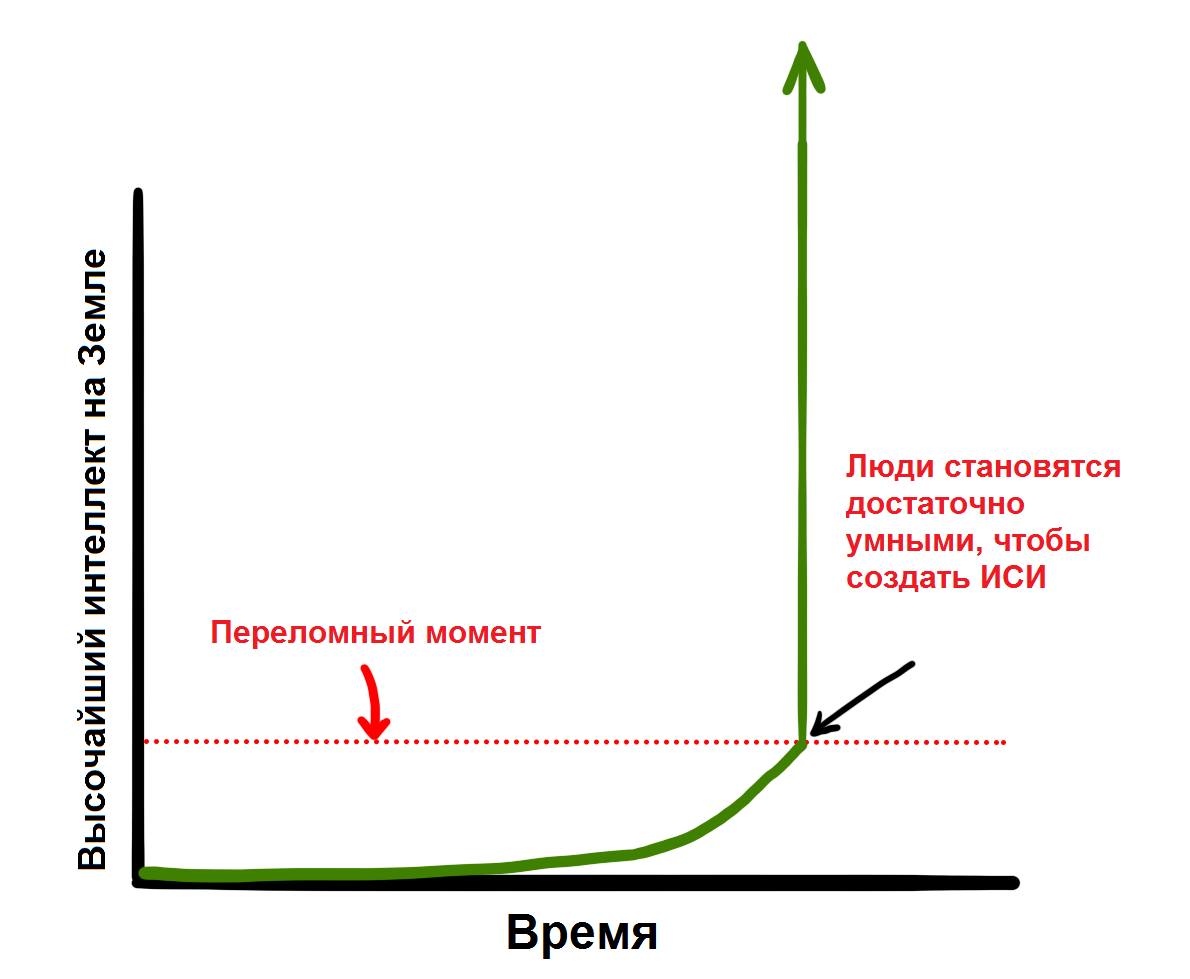

Эволюция медленно и постепенно развивала биологический мозг на протяжении сотен миллионов лет, и если люди создадут машину со сверхинтеллектом, в некотором смысле мы превзойдем эволюцию.

Или же это будет частью эволюции — возможно, эволюция так и действует, что интеллект развивается постепенно, пока не достигнет переломного момента, предвещающего новое будущее для всех живых существ.

По причинам, которые мы обсудим позже, огромная часть научного сообщества считает, что вопрос не в том, доберемся ли мы до этого переломного момента, а когда.

Где мы окажемся после этого?

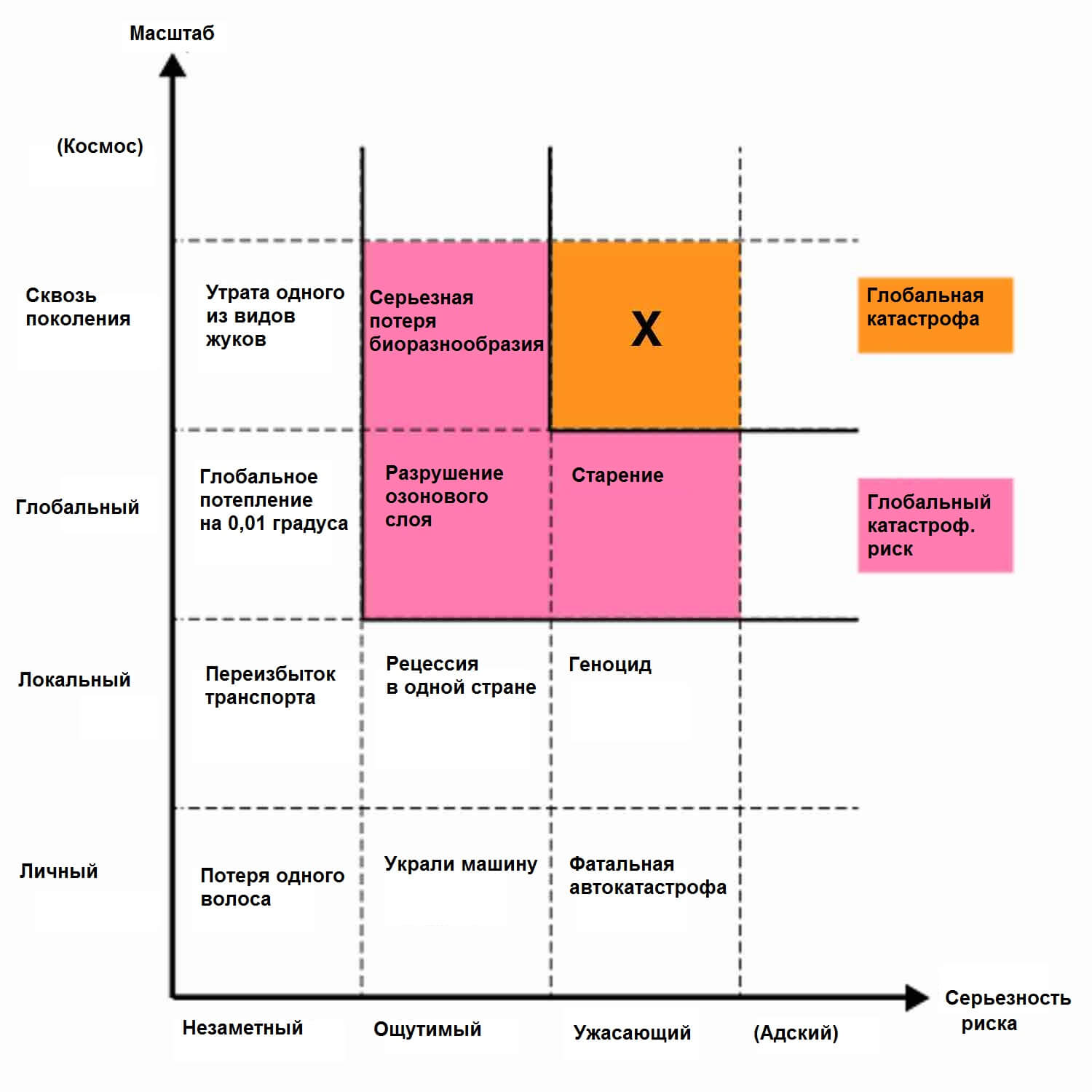

Думаю, никто в этом мире, ни я, ни вы, не сможет сказать, что случится, когда мы достигнем переломного момента. Оксфордский философ и ведущий теоретик ИИ Ник Бостром считает, что мы можем свести все возможные результаты к двум большим категориям.

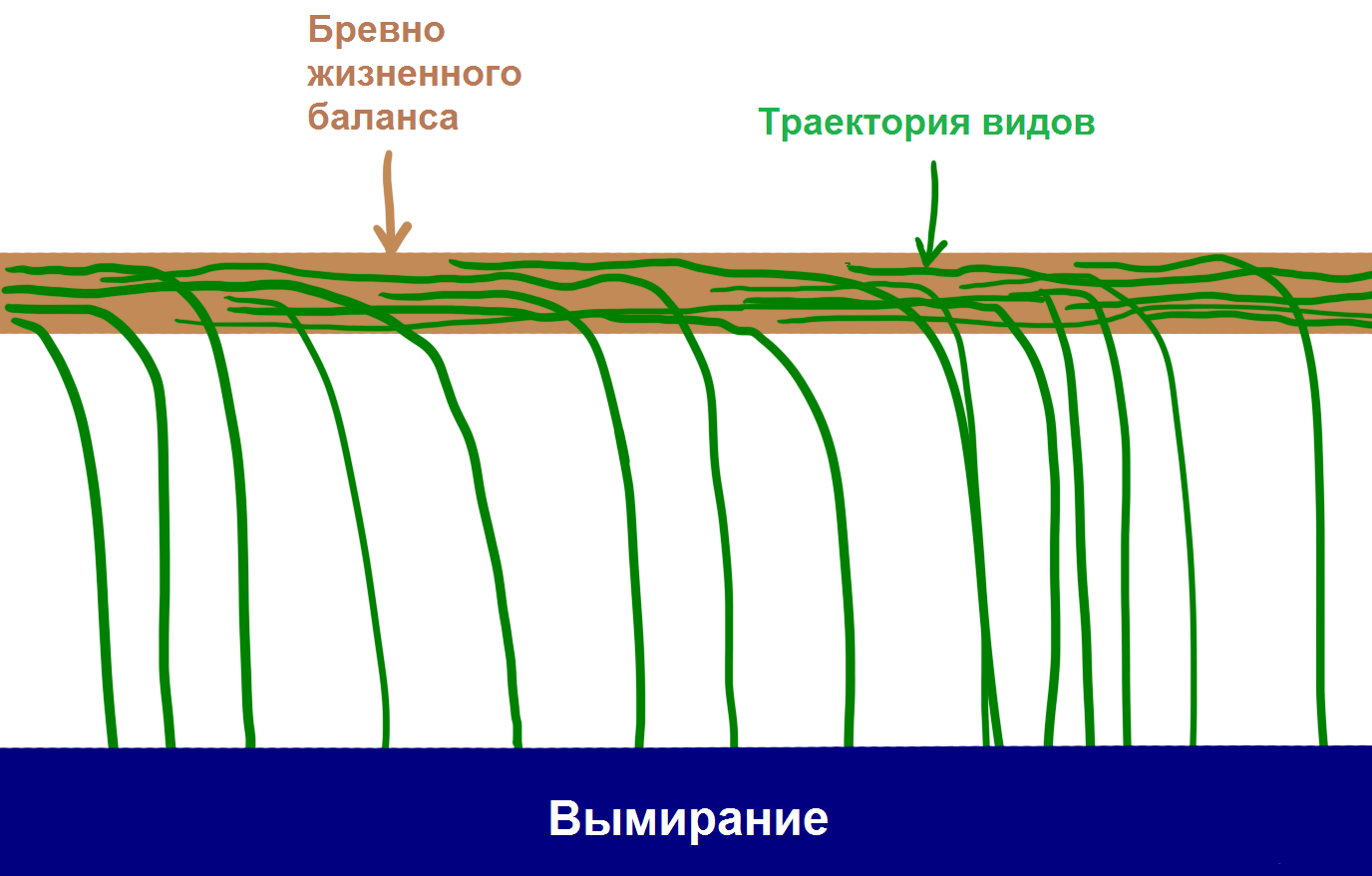

Во-первых, глядя на историю, мы знаем о жизни следующее: виды появляются, существуют определенное время, а затем неизбежно падают с бревна жизненного баланса и вымирают.

«Все виды вымирают» было таким же надежным правилом в истории, как и «все люди когда-нибудь умирают».

99,9% видов упали с жизненного бревна, и совершенно очевидно, что если некоторый вид держится на этом бревне слишком долго, порыв природного ветра или внезапный астероид перевернет это бревно. Бостром называет вымирание состоянием аттрактора — места, на котором все виды балансируют, чтобы не упасть туда, откуда не вернулся пока ни один вид.

И хотя большинство ученых признают, что у ИСИ будет возможность обречь людей на вымирание, многие также верят, что использование возможностей ИСИ позволит отдельным людям (и виду в целом) достичь второго состояния аттрактора — видового бессмертия. Бостром считает, что бессмертие вида такой же аттрактор, как и вымирание видов, то есть, если мы доберемся до этого, мы будем обречены на вечное существование. Таким образом, даже если все виды до текущего дня падали с этой палки в омут вымирания, Бостром считает, что у бревна есть две стороны, и просто не появился на Земле такой интеллект, который поймет, как упасть на другую сторону.

Если Бостром и другие правы, а, судя по всей доступной нам информации, они вполне могут таковыми быть, нам нужно принять два весьма шокирующих факта:

- Появление ИСИ впервые в истории откроет возможность для вида достичь бессмертия и выпасть из фатального цикла вымирания.

- Появление ИСИ окажет настолько невообразимо огромное влияние, что, скорее всего, столкнет человечество с этого бревна в одну или другую сторону.

Вполне возможно, что когда эволюция достигает такого переломного момента, она всегда ставит точку в отношениях людей с потоком жизни и создает новый мир, с людьми или без.

Отсюда вытекает один интересный вопрос, который только лентяй не задал бы: когда мы доберемся до этого переломного момента и куда он нас определит? Никто в мире не знает ответа на этот двойной вопрос, но очень много умных людей десятилетиями пытались это понять. Оставшуюся часть статьи мы будем выяснять, к чему они пришли.

Начнем с первой части этого вопрос: когда мы должны достичь переломного момента? Другими словами: сколько осталось времени до тех пор, пока первая машина не достигнет сверхинтеллекта?

Мнения разнятся от случая к случаю. Многие, среди которых профессор Вернор Виндж, ученый Бен Герцель, соучредитель Sun Microsystems Билл Джой, футуролог Рэй Курцвейл, согласились с экспертом в области машинного обучения Джереми Говардом, когда он представил на TED Talk следующий график:

График Говарда

Эти люди разделяют мнение, что ИСИ появится скоро — этот экспоненциальный рост, который сегодня кажется нам медленным, буквально взорвется в ближайшие несколько десятилетий.

Другие вроде соучредителя Microsoft Пола Аллена, психолога исследований Гари Маркуса, компьютерного эксперта Эрнеста Дэвиса и технопредпринимателя Митча Капора считают, что мыслители вроде Курцвейла серьезно недооценивают масштабы проблемы, и думают, что мы не так-то и близки к переломному моменту.

Лагерь Курцвейла возражает, что единственная недооценка, которая имеет место, — это игнорирование экспоненциального роста, и можно сравнить сомневающихся с теми, кто смотрел на медленно расцветающий интернет в 1985 году и утверждал, что он не будет иметь влияния на мир в ближайшем будущем.

«Сомневающиеся» могут парировать, мол, что прогрессу сложнее делать каждый последующий шаг, когда дело доходит до экспоненциального развития интеллекта, что нивелирует типичную экспоненциальную природу технологического прогресса. И так далее.

Третий лагерь, в котором находится Ник Бостром, не согласен ни с первыми, ни со вторыми, утверждая, что а) все это абсолютно может произойти в ближайшем будущем; и б) нет никаких гарантий в том, что это произойдет вообще или потребует больше времени.

Другие же вроде философа Хьюберта Дрейфуса считают, что все эти три группы наивно полагают, что переломный момент вообще будет, а также что, скорее всего, мы никогда не доберемся до ИСИ.

Что получается, когда мы складываем все эти мнения вместе?

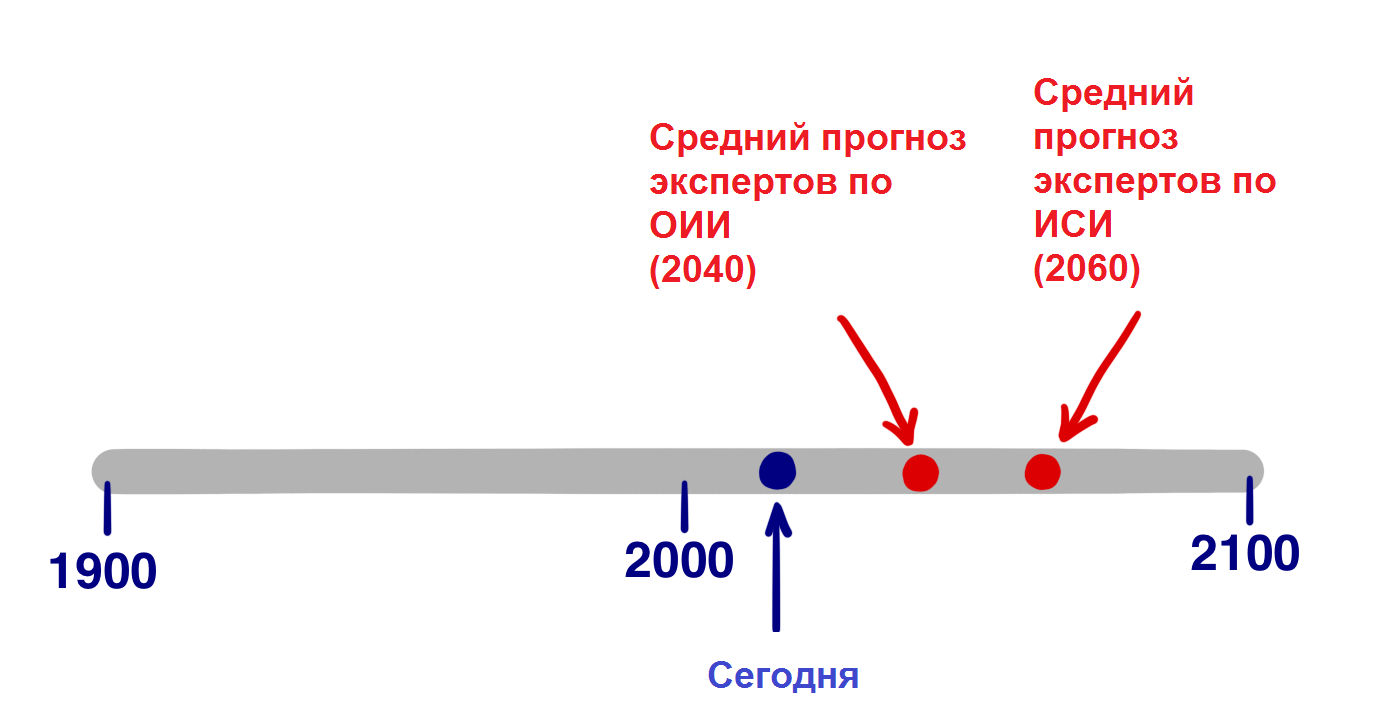

В 2013 году Бостром провел опрос, в котором опросил сотни экспертов в сфере искусственного интеллекта в ходе ряда конференций на следующую тему: «Каков будет ваш прогноз по достижению ОИИ человеческого уровня?» и попросил назвать оптимистичный год (в который мы будем иметь ОИИ с 10-процентным шансом), реалистичное предположение (год, в который у нас с 50-процентной вероятностью будет ОИИ) и уверенное предположение (самый ранний год, в который ОИИ появится с 90-процентной вероятностью). Вот результаты:

- Средний оптимистичный год (10%): 2022

- Средний реалистичный год (50%): 2040

- Средний пессимистичный год (90%): 2075

Среднестатистические опрошенные считают, что через 25 лет мы скорее будем иметь ОИИ, чем нет. 90-процентная вероятность появления ОИИ к 2075 году означает, что если вы сейчас еще довольно молоды, это наверняка произойдет при вашей жизни.

Отдельное исследование, проведенное недавно Джеймсом Барратом (автором нашумевшей и очень хорошей книги «Наше последнее изобретение», отрывки из которой я представлял вниманию читателей Hi-News.ru) и Беном Герцелем на ежегодной конференции, посвященной ОИИ, AGI Conference, просто показало мнения людей относительно года, в который мы доберемся до ОИИ: к 2030, 2050, 2100, позже или никогда. Вот результаты:

- К 2030: 42% респондентов

- К 2050: 25%

- К 2100: 20%

- После 2100: 10%

- Никогда: 2%

Похоже на результаты Бострома. В опросе Баррата, более двух третей опрошенных считают, что ОИИ будет здесь к 2050 году, и менее половины считают, что ОИИ появится в ближайшие 15 лет. Также бросается в глаза то, что только 2% опрошенных в принципе не видят ОИИ в нашем будущем.

Но ОИИ — это не переломный момент, как ИСИ. Когда, по мнению экспертов, у нас будет ИСИ?

Бостром опросил экспертов, когда мы достигнем ИСИ: а) через два года после достижения ОИИ (то есть почти мгновенно вследствие взрыва интеллекта); б) через 30 лет. Результаты?

Среднее мнение сложилось так, что быстрый переход от ОИИ к ИСИ произойдет с 10-процентной вероятностью, но через 30 лет или меньше он произойдет с 75-процентной вероятностью.

Из этих данных мы не знаем, какую дату респонденты назвали бы 50-процентным шансом появления ИСИ, но на основе двух ответов выше давайте допустим, что это 20 лет.

Ведущие мировые эксперты из области ИИ считают, что переломный момент настанет в 2060 году (ОИИ появится в 2040 году + понадобится лет 20 на переход от ОИИ к ИСИ).

Конечно, все вышеперечисленные статистики являются спекулятивными и просто представляют мнение экспертов в сфере искусственного интеллекта, но они также указывают, что большинство заинтересованных людей сходятся в том, что к 2060 году ИСИ, скорее всего, должен прибыть. Всего через 45 лет.

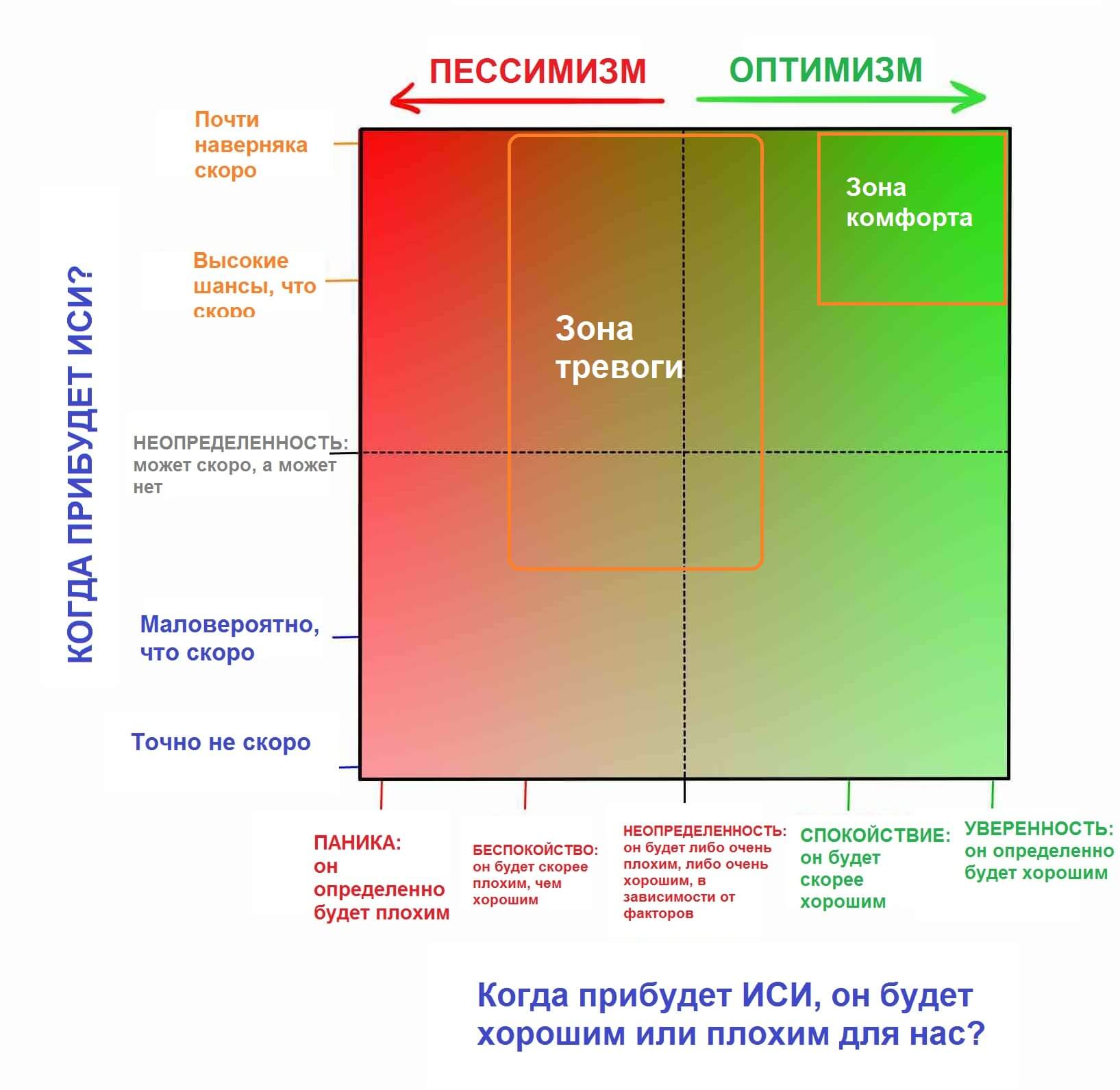

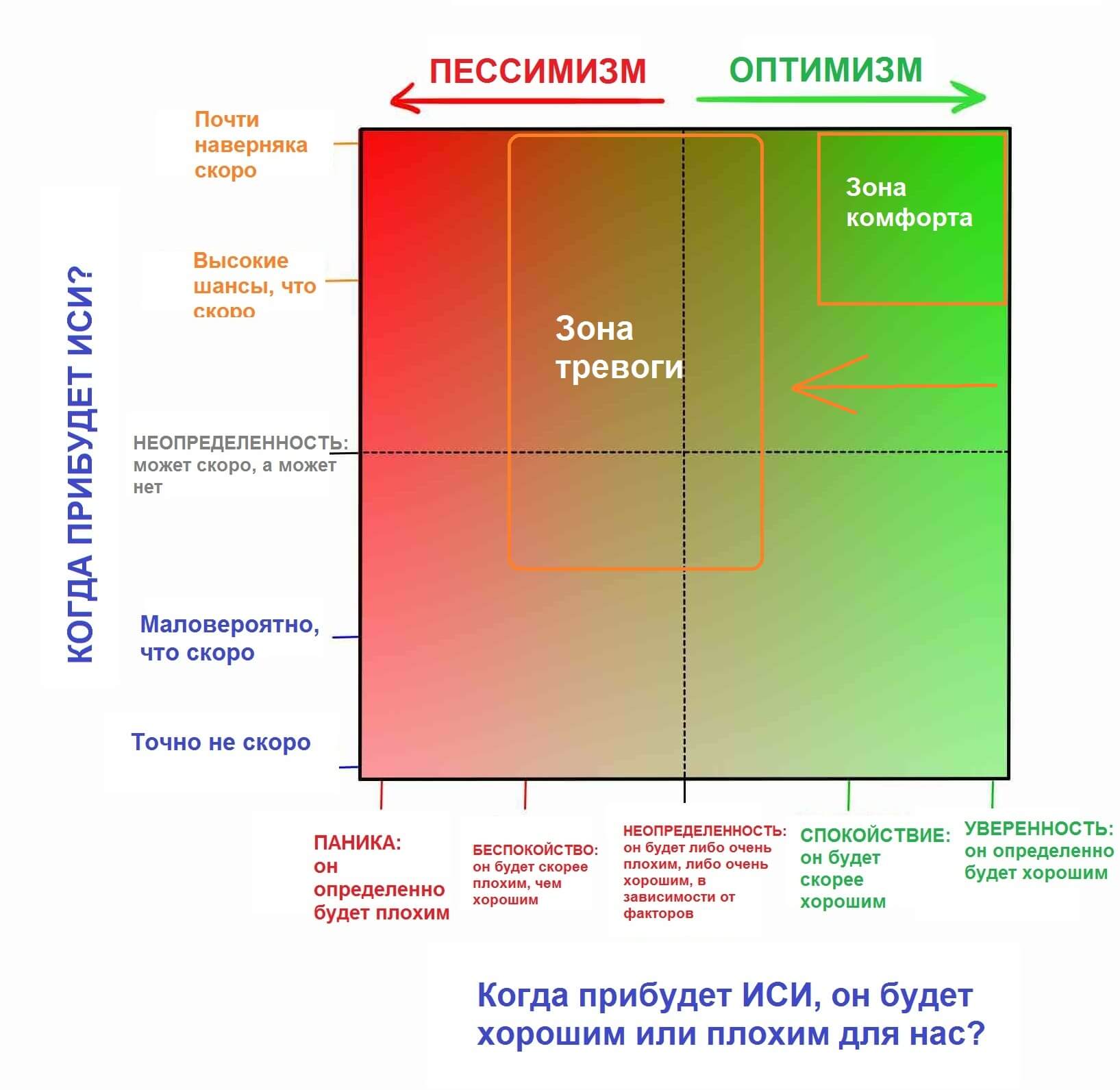

Перейдем ко второму вопросу. Когда мы дойдем до переломного момента, по какую сторону фатального выбора нас определит?

Сверхинтеллект будет обладать мощнейшей силой, и критическим вопросом для нас будет следующий:

Кто или что будет контролировать эту силу и какой будет его мотивация?

Ответ на этот вопрос будет зависеть от того, получит ИСИ невероятно мощное развитие, неизмеримо ужасающее развитие или что-то между этими двумя вариантами.

Конечно, сообщество экспертов пытается ответить и на эти вопросы. Опрос Бострома проанализировал вероятность возможных последствий влияния ОИИ на человечество, и выяснилось, что с 52-процентным шансом все пройдет очень хорошо и с 31-процентным шансом все пройдет либо плохо, либо крайне плохо. Опрос, прикрепленный в конце предыдущей части этой темы, проведенный среди вас, дорогие читатели Hi-News, показал примерно такие же результаты. Для относительно нейтрального исхода вероятность составила только 17%. Другими словами, мы все считаем, что появление ОИИ станет грандиозным событием. Также стоит отметить, что этот опрос касается появления ОИИ — в случае с ИСИ, процент нейтральности будет ниже.

Прежде чем мы углубимся еще дальше в рассуждения о плохой и хорошей сторонах вопроса, давайте объединим обе части вопроса — «когда это произойдет?» и «хорошо это или плохо?» в таблицу, которая охватывает взгляды большинства экспертов.

О главном лагере мы поговорим через минуту, но сначала определитесь со своей позицией. Скорее всего, вы находитесь там же, где и я, до того как стал заниматься этой темой. Есть несколько причин, по которым люди вообще не думают на эту тему:

- Как уже упоминалось в первой части, фильмы серьезно запутали людей и факты, представляя нереалистичные сценарии с искусственным интеллектом, которые привели к тому, что мы вообще не должны воспринимать ИИ всерьез. Джеймс Баррат сравнил эту ситуацию с тем, как если бы Центры по контролю заболеваний выпустили серьезное предупреждение о вампирах в нашем будущем.

- Из-за так называемых когнитивных предубеждений нам очень трудно поверить в реальность чего-то, пока у нас нет доказательств. Можно уверенно представить компьютерщиков 1988 года, которые регулярно обсуждали далеко идущие последствия появления интернета и чем он мог стать, но люди едва ли верили, что он изменит их жизнь, пока этого не случилось на самом деле. Просто компьютеры не умели делать этого в 1988 году, и люди просто смотрели на свои компьютеры и думали: «Серьезно? Это то, что изменит мир?». Их воображение было ограничено тем, чему их научил личный опыт, они знали, что такое компьютер, и было сложно представить, на что компьютер станет способным в будущем. То же самое происходит сейчас с ИИ. Мы слышали, что он станет серьезной штукой, но поскольку пока не столкнулись с ним лицом к лицу и в целом наблюдаем довольно слабые проявления ИИ в нашем современном мире, нам довольно трудно поверить, что он кардинально изменит нашу жизнь. Именно против этих предубеждений выступают многочисленные эксперты из всех лагерей, а также заинтересованные люди: пытаются привлечь наше внимание сквозь шум повседневного коллективного эгоцентризма.

- Даже если бы мы поверили во все это — сколько раз вы сегодня задумывались о том факте, что проведете остаток вечности в небытии? Немного, согласитесь. Даже если этот факт намного важнее всего, чем вы занимаетесь изо дня в день. Все потому, что наши мозги обычно сосредоточены на небольших повседневных вещах, вне зависимости от того, насколько бредовой будет долгосрочная ситуация, в которой мы оказались. Просто мы так устроены.

Одна из целей настоящей статьи — вывести вас из лагеря под названием «Мне нравится думать о других вещах» и поместить в лагерь экспертов, даже если вы просто стоите на распутье между двумя пунктирными линиями на квадрате выше, будучи полностью неопределившимися.

В ходе исследований становится очевидно, что мнения большинства людей быстро уходят в сторону «главного лагеря», а три четверти экспертов попадают в два подлагеря в главном лагере.

Мы полностью посетим оба этих лагеря. Давайте начнем с веселого.

Почему будущее может быть нашей величайшей мечтой?

По мере того, как мы изучаем мир ИИ, мы обнаруживаем на удивление много людей в зоне комфорта. Люди в правом верхнем квадрате гудят от волнения. Они считают, что мы упадем по хорошую сторону бревна, а также уверены, что мы неизбежно к этому придем. Для них будущее — это все только самое лучшее, о чем только можно мечтать.

Пункт, который отличает этих людей от других мыслителей, состоит не в том, что они хотят оказаться на счастливой стороне — а в том, что они уверены, что нас ждет именно она.

Эта уверенность выходит из споров. Критики считают, что она исходит от ослепительного волнения, которое затмевает потенциальные негативные стороны. Но сторонники говорят, что мрачные прогнозы всегда наивны; технологии продолжают и всегда будут помогать нам больше, чем вредить.

Вы вправе выбрать любое из этих мнений, но отложите скептицизм и хорошенько взгляните на счастливую сторону бревна баланса, попытавшись принять тот факт, что все, о чем вы читаете, возможно, уже произошло. Если бы вы показали охотникам-собирателям наш мир уюта, технологий и бесконечного изобилия, им он показался бы волшебным вымыслом — а мы ведем себя достаточно скромно, не в силах допустить, что такая же непостижимая трансформация ждет нас в будущем.

Ник Бостром описывает три пути, по которым может пойти сверхразумная система искусственного интеллекта:

- Оракул, который может ответить на любой точно поставленный вопрос, включая сложные вопросы, на которые люди не могут ответить — к примеру, «как сделать автомобильный двигатель более эффективным?». Google — примитивный тип «оракула».

- Джинн, который выполнит любую команду высокого уровня — использует молекулярный ассемблер, чтобы создать новую, более эффективную версию автомобильного двигателя — и будет ждать следующей команды.

- Суверен, который получит широкий доступ и возможность свободно функционировать в мире, принимая собственные решения и улучшая процесс. Он изобретет более дешевый, быстрый и безопасный способ частного передвижения, нежели автомобиль.

Эти вопросы и задачи, которые кажутся сложными для нас, покажутся сверхразумной системе будто кто-то попросил улучшить ситуацию «у меня карандаш упал со стола», в которой вы просто подняли бы его и положили обратно.

Элиэзер Юдковский, американский специалист по искусственному интеллект, хорошо подметил:

«Сложных проблем не существует, только проблемы, которые сложны для определенного уровня интеллекта. Перейти на ступеньку выше (в плане интеллекта), и некоторые проблемы внезапно из разряда «невозможных» перейдут в стан «очевидных». Еще на ступеньку выше — и все они станут очевидными».

Есть много нетерпеливых ученых, изобретателей и предпринимателей, которые на нашей таблице выбрали себе зону уверенного комфорта, но для прогулки к лучшему в этом лучшем из миров нам нужен только один гид.

Рэй Курцвейл вызывает двоякие ощущения. Некоторые боготворят его идеи, некоторые презирают. Некоторые держатся посередке — Дуглас Хофштадтер, обсуждая идеи книг Курцвейла, красноречиво подметил, что «это как если бы вы взяли много хорошей еды и немного собачьих какашек, а затем смешали все так, что невозможно понять, что хорошо, а что плохо».

Нравятся вам его идеи или нет, мимо них невозможно пройти без тени интереса. Он начал изобретать вещи еще будучи подростком, а в последующие годы изобрел несколько важных вещей, включая первый планшетный сканер, первый сканер, конвертирующий текст в речь, хорошо известный музыкальный синтезатор Курцвейла (первое настоящее электрическое пианино), а также первый коммерчески успешный распознаватель речи. Также он автор пяти нашумевших книг. Курцвейла ценят за его смелые предсказания, и его «послужной список» весьма хорош — в конце 80-х, когда интернет был еще в зачаточном состоянии, он предположил, что к 2000-м годам Сеть станет глобальным феноменом. The Wall Street Journal назвал Курцвейла «беспокойным гением», Forbes — «глобальной думающей машиной», Inc. Magazine — «законным наследником Эдисона», Билл Гейтс — «лучшим из тех, кто прогнозирует будущее искусственного интеллекта». В 2012 году сооснователь Google Ларри Пейдж пригласил Курцвейла на пост технического директора. В 2011 году он стал соучредителем Singularity University, который приютило NASA и который частично спонсирует Google.

Его биография имеет значение. Когда Курцвейл рассказывает о своем видении будущего, это похоже на бред сумасшедшего, но по-настоящему сумасшедшее в этом то, что он далеко не сумасшедший — он невероятно умный, образованный и здравомыслящий человек. Вы можете считать, что он ошибается в прогнозах, но он не дурак. Прогнозы Курцвейла разделяют многие эксперты «комфортной зоны», Питер Диамандис и Бен Герцель. Вот что произойдет, по его мнению.

Хронология

Курцвейл считает, что компьютеры дойдут до уровня общего искусственного интеллекта (ОИИ) к 2029 году, а к 2045 у нас не только будет искусственный сверхинтеллект, но и совершенно новый мир — время так называемой сингулярности. Его хронология ИИ до сих пор считается возмутительно преувеличенной, но за последний 15 лет быстрое развитие систем узконаправленного искусственного интеллекта (УИИ) заставило многих экспертов перейти на сторону Курцвейла. Его предсказания по-прежнему остаются более амбициозными, чем в опросе Бострома (ОИИ к 2040, ИСИ к 2060), но не намного.

По Курцвейлу, к сингулярности 2045 года приводит три одновременных революции в сферах биотехнологий, нанотехнологий и, что более важно, ИИ. Но прежде чем мы продолжим — а нанотехнологии неотрывно следуют за искусственным интеллектом, — давайте уделим минуту нанотехнологиям.

Несколько слов о нанотехнологиях

Нанотехнологиями мы обычно называем технологии, которые имеют дело с манипуляцией материи в пределах 1-100 нанометров. Нанометр — это одна миллиардная метра, или миллионная часть миллиметра; в пределах 1-100 нанометров можно уместить вирусы (100 нм в поперечнике), ДНК (10 нм в ширину), молекулы гемоглобина (5 нм), глюкозы (1 нм) и другое. Если нанотехнологии когда-нибудь станут нам подвластны, следующим шагом будут манипуляции с отдельными атомами, которые меньше всего на один порядок (~,1 нм).

Чтобы понять, где люди сталкиваются с проблемами, пытаясь управлять материей в таких масштабах, давайте перенесемся на больший масштаб. Международная космическая станция находится в 481 километре над Землей. Если бы люди были гигантами и головой задевали МКС, они были бы в 250 000 раз больше, чем сейчас. Если вы увеличите что-то от 1 до 100 нанометров в 250 000 раз, вы получите 2,5 сантиметра. Нанотехнологии — это эквивалент человека высотой с орбиту МКС, который пытается управлять вещами размером с песчинку или глазное яблоко. Чтобы добраться до следующего уровня — управления отдельными атомами — гиганту придется тщательно позиционировать объекты диаметром в 1/40 миллиметра. Обычным людям понадобится микроскоп, чтобы их разглядеть.

Впервые о нанотехнологиях заговорил Ричард Фейнман в 1959 году. Тогда он сказал: «Принципы физики, насколько я могу судить, не говорят против возможности управления вещами атом за атомом. В принципе, физик мог бы синтезировать любое химическое вещество, записанное химиком. Как? Размещая атомы там, где говорит химик, чтобы получить вещество». В этом вся простота. Если вы знаете, как передвигать отдельные молекулы или атомы, вы можете практически все.

Нанотехнологии стали серьезным научным полем в 1986 году, когда инженер Эрик Дрекслер представил их основы в своей фундаментальной книге «Машины создания», однако сам Дрекслер считает, что те, кто хочет узнать больше о современных идеях в нанотехнологиях, должны прочитать его книгу 2013 года «Полное изобилие» (Radical Abundance).

Несколько слов о «серой слизи»

Углубляемся в нанотехнологии. В частности, тема «серой слизи» — одна из не самых приятных тем в области нанотехнологий, о которой нельзя не сказать. В старых версиях теории нанотехнологий был предложен метод наносборки, включающий создание триллионов крошечных нанороботов, которые будут работать совместно, создавая что-то. Один из способов создания триллионов нанороботов — создать одного, который сможет самовоспроизводиться, то есть из одного — два, из двух — четыре и так далее. За день появится несколько триллионов нанороботов. Такова сила экспоненциального роста. Забавно, не так ли?

Забавно, но ровно до тех пор, пока не приведет к апокалипсису. Проблема в том, что сила экспоненциального роста, которая делает довольно удобным способ быстрого создания триллиона наноботов, делает саморепликацию страшной штукой в перспективе. Что, если система заглючит, и вместо того, чтобы остановить репликацию на паре триллионов, наноботы продолжат плодиться? Что, если весь этот процесс зависит от углерода? Биомасса Земли содержит 10^45 атомов углерода. Нанобот должен состоять из порядка 10^6 атомов углерода, поэтому 10^39 наноботов сожрут всю жизнь на Земле, и это случится всего за 130 репликаций. Океан наноботов («серая слизь») наводнит планету. Ученые думают, что наноботы смогут реплицироваться за 100 секунд, а это значит, что простая ошибка может убить всю жизнь на Земле всего за 3,5 часа.

Может быть и хуже — если до нанотехнологий дойдут руки террористов и неблагоприятно настроенных специалистов. Они могли бы создать несколько триллионов наноботов и запрограммировать их тихо распространиться по миру за пару недель. Затем, по одному нажатию кнопки, всего за 90 минут они съедят вообще все, без шансов.

Хотя эта страшилка широко обсуждалась в течение многих лет, хорошая новость в том, что это всего лишь страшилка. Эрик Дрекслер, который ввел термин «серая слизь», на днях рассказал следующее: «Люди любят страшилки, и эта входит в разряд страшилок о зомби. Эта идея сама по себе уже ест мозги».

После того как мы доберемся до самого низа нанотехнологий, мы сможем использовать их для создания технических устройств, одежды, еды, биопродуктов — клеток крови, борцов с вирусами и раком, мышечных тканей и т. п. — чего угодно. И в мире, который использует нанотехнологии, стоимость материала больше не будет привязана к его дефициту или сложности процесса его изготовления, а скорее к сложности атомной структуры. В мире нанотехнологий алмаз может стать дешевле ластика.

Мы пока и близко не там. И не совсем понятно, недооцениваем мы или переоцениваем сложность этого пути. Однако все идет к тому, что нанотехнологии не за горами. Курцвейл предполагает, что уже к 2020-м годам они у нас будут. Мировые государства знают, что нанотехнологии могут обещать грандиозное будущее, и поэтому инвестируют в них многие миллиарды.

Просто представьте, какие возможности получит сверхразумный компьютер, если доберется до надежного наномасштабного ассемблера. Но нанотехнологии — это наша идея, и мы пытаемся ее оседлать, нам сложно. Что, если для системы ИСИ они будут просто шуткой, и сам ИСИ придумает технологии, которые будут в разы мощнее всего, что мы вообще в принципе можем предположить? Мы же договорились: никто не может предположить, на что будет способен искусственный сверхинтеллект? Есть мнение, что наши мозги неспособны предсказать даже минимума из того, что будет.

Что ИИ мог бы сделать для нас?

Вооружившись сверхинтеллектом и всеми технологиями, которые мог бы создать сверхинтеллект, ИСИ будет в состоянии, вероятно, решить все проблемы человечества.

Глобальное потепление? ИСИ сначала прекратит выбросы углекислого газа, придумав массу эффективных способов добычи энергии, не связанных с ископаемым топливом. Затем он придумает эффективный инновационный способ удаления избытка CO2 из атмосферы. Рак и другие заболевания? Не проблема — здравоохранение и медицина изменятся так, что невозможно представить. Мировой голод? ИСИ будет использовать нанотехнологии для создания мяса, идентичного натуральному, с нуля, настоящее мясо.

Нанотехнологии смогут превратить груду мусора в чан свежего мяса или другой еды (необязательно даже в привычной форме — представьте гигантский яблочный куб) и распространить всю эту еду по миру, используя продвинутые системы транспортировки. Конечно, это будет замечательно для животных, которым больше не придется умирать ради еды. ИСИ также может сделать много другого вроде сохранения вымирающих видов или даже возврата уже вымерших по сохраненной ДНК. ИСИ может разрешить наши самые сложные макроэкономические проблемы — наши самые сложные экономические дебаты, вопросы этики и философии, мировой торговли — все это будет мучительно очевидно для ИСИ.

Но есть кое-что особенное, что ИСИ мог бы сделать для нас. Манящее и дразнящее, что изменило бы все: ИСИ может помочь нам справиться со смертностью. Постепенно постигая возможности ИИ, возможно, и вы пересмотрите все свои представления о смерти.

У эволюции не было никаких причин продлевать нашу продолжительность жизни больше, чем она есть сейчас. Если мы живем достаточно долго, чтобы нарожать и воспитать детей до того момента, когда они смогут постоять за себя, эволюции этого достаточно. С эволюционной точки зрения, 30+ лет для развития достаточно, и нет никаких причин для мутаций, продлевающих жизнь и снижающих ценность естественного отбора. Уильям Батлер Йетс назвал наш вид «душой, прикрепленной к умирающему животному». Не очень-то весело.

И поскольку все мы когда-нибудь умираем, мы живем с мыслью о том, что смерть неизбежна. Мы думаем о старении со временем — продолжая двигаться вперед и не имея возможности остановить этот процесс. Но мысль о смерти вероломна: захваченные ею, мы забываем жить. Ричард Фейнман писал:

«В биологии есть замечательная вещь: в этой науке нет ничего, что говорило бы о необходимости смерти. Если мы хотим создать вечный двигатель, мы понимаем, что обнаружили достаточно законов в физике, которые либо указывают на невозможность этого, либо на то, что законы ошибочны. Но в биологии нет ничего, что указывало бы на неизбежность смерти. Это приводит меня к мысли, что она не так уж и неизбежна, и остается только вопрос времени, прежде чем биологи обнаружат причину этой проблемы, этого ужасного универсального заболевания, оно будет излечено».

Дело в том, что старение никак не связано со временем. Старение заключается в том, что физические материалы тела изнашиваются. Части автомобиля тоже деградируют — но разве это старение неизбежно? Если вы будете ремонтировать автомобиль по мере изнашивания частей, он будет работать вечно. Человеческое тело ничем не отличается — просто более сложное.

Курцвейл говорит о разумных, подключенных к Wi-Fi наноботах в кровотоке, которые могли бы выполнять бесчисленные задачи для человеческого здоровья, включая регулярный ремонт или замену изношенных клеток в любой части тела. Если усовершенствовать этот процесс (или найти альтернативу, предложенную более умным ИСИ), он не только будет поддерживать тело здоровым, он может обратить вспять старение. Разница между телом 60-летнего и 30-летнего заключается в горстке физических моментов, которые можно было бы исправить при наличии нужных технологий. ИСИ мог бы построить машину, в которую человек бы заходил 60-летним, а выходил 30-летним.

Даже деградирующий мозг можно было бы обновить. ИСИ наверняка знал бы, как проделать это, не затрагивая данные мозга (личность, воспоминания и т. д.). 90-летний старик, страдающий от полной деградации мозга, мог бы пройти переподготовку, обновиться и вернуться в начало своей жизненной карьеры. Это может показаться абсурдным, но тело — это горстка атомов, и ИСИ наверняка мог бы с легкостью ими манипулировать, любыми атомными структурами. Все не так абсурдно.

Курцвейл также считает, что искусственные материалы будут интегрироваться в тело все больше и больше по мере движения времени. Для начала органы можно было бы заменить сверхпродвинутыми машинными версиями, которые работали бы вечно и никогда не подводили. Затем мы могли бы провести полный редизайн тела, заменить красные кровяные клетки идеальными наноботами, которые двигались бы самостоятельно, устранив необходимость в сердце вообще. Мы также могли бы улучшить наши когнитивные способности, начать думать в миллиарды быстрее и получить доступ ко всей доступной человечеству информации с помощью облака.

Возможности для постижения новых горизонтов были бы воистину безграничными. Людям удалось наделить секс новым назначением, они занимаются им для удовольствия, а не только для воспроизводства. Курцвейл считает, что мы можем проделать то же самое с едой. Наноботы могли бы доставлять идеальное питание прямо в клетки тела, позволяя нездоровым веществам проходить через тело насквозь. Теоретик нанотехнологий Роберт Фрейтас уже разработал замену кровяным клеткам, которые, будучи имплементированными в тело человека, могут позволить ему не дышать в течение 15 минут — и это придумал человек. Представьте, когда власть получит ИСИ.

В конце концов, Курцвейл считает, что люди достигнут точки, когда станут полностью искусственными; времени, когда мы будем смотреть на биологические материалы и думать о том, насколько примитивными были; времени, когда мы будем читать о ранних этапах истории человечества, поражаясь тому, как микробы, несчастные случаи, заболевания или просто старость могли убить человека против его воли. В конечном итоге люди победят собственную биологию и станут вечными — таков путь по счастливую сторону бревна баланса, о котором мы говорим с самого начала. И люди, которые в это верят, уверены также и в том, что нас ждет такое будущее очень и очень скоро.

Вы наверняка не будете удивлены тому, что идеи Курцвейла вызвали суровую критику. Его сингулярность в 2045 году и последующая вечная жизнь для людей получили название «вознесение ботаников» или «разумное создание людей с IQ 140». Другие усомнились в оптимистичных временных рамках, понимании тела и мозга человека, напомнили о законе Мура, который пока никуда не девается. На каждого эксперта, который верит в идеи Курцвейла, приходится три, которые считают, что он ошибается.

Но самое интересное в этом то, что большинство экспертов, не согласных с ним, в целом не говорят, что это невозможно. Вместо того чтобы сказать «ерунда, такого никогда не случится», они говорят что-то вроде «все это случится, если мы доберемся до ИСИ, но загвоздка как раз в этом». Бостром, один из признанных экспертов ИИ, предупреждающих об опасности ИИ, также признает:

«Едва ли останется хоть какая-нибудь проблема, которую сверхинтеллект не в силах будет разрешить или хотя бы помочь нам решить. Болезни, бедность, разрушение окружающей среды, страдания всех видов — все это сверхинтеллект при помощи нанотехнологий сможет решить в момент. Также сверхинтеллект может дать нам неограниченный срок жизни, остановив и обратив вспять процессы старения, используя наномедицину или возможность загружать нас в облако. Сверхинтеллект также может создать возможности для бесконечного увеличения интеллектуальных и эмоциональных возможностей; он может посодействовать нам в создании мира, в котором мы будем жить в радости и понимании, приближаясь к своим идеалам и регулярно воплощая свои мечты».

Это цитата одного из критиков Курцвейла, однако, признающего, что все это возможно, если нам удастся создать безопасный ИСИ. Курцвейл просто определил, каким должен стать искусственный сверхинтеллект, если он вообще станет возможным. И если он будет добрым богом.

Наиболее очевидная критика сторонников «зоны комфорта» заключается в том, что они могут чертовски ошибаться, оценивая будущее ИСИ. В своей книге «Сингулярность» Курцвейл посвятил 20 страниц из 700 потенциальным угрозам ИСИ. Вопрос не в том, когда мы доберемся до ИСИ, вопрос в том, какой будет его мотивация. Курцвейл отвечает на этот вопрос с осторожностью: «ИСИ вытекает из многих разрозненных усилий и будет глубоко интегрирован в инфраструктуру нашей цивилизации. По сути, он будет тесно встроен в наш организм и мозг. Он будет отражать наши ценности, потому что будет с нами одним».

Но если ответ таков, почему так много умных людей в этом мире обеспокоены будущим искусственного интеллекта? Почему Стивен Хокинг говорит, что разработка ИСИ «может означать конец человеческой расы»? Билл Гейтс говорит, что он «не понимает людей, которые не обеспокоены» этим. Элон Маск опасается, что мы «призываем демона». Почему многие эксперты считают ИСИ самой большой угрозой для человечества? Читайте ниже.

Часть третья: почему искусственный интеллект может стать нашим последним изобретением?

Одна из причин, которая привела меня к ИИ, состоит в том, что тема «плохих роботов» всегда смущала меня. Все фильмы о механических злыднях казались совершенно нереальными, и в целом сложно представить реальную ситуацию, в которой ИИ мог быть воистину опасным. Роботов делаем мы, так почему бы не делать их, упреждая любые негативные последствия? Разве мы не соблюдаем правовые критерии и этические нормы? Разве мы не можем в любой момент отрезать ИИ питание и погасить его? С чего бы роботам вообще делать пакости? Почему робот вообще должен чего-то «хотеть»? Мой скепсис был непробиваем. Но я продолжал впитывать, что говорят умные люди об этом.

Эти люди придерживаются примерно такого мнения

Людей в «зоне тревоги» нельзя назвать паникерами или «всёпропальщиками», но они нервничают и очень напряжены. Находиться в центре таблицы не означает, что вы считаете прибытие ИСИ нейтральным событием — у таких людей есть свой лагерь, — это означает, что вы верите как в плохие, так и в хорошие стороны этого пришествия, но до конца не уверены в распределении процентов вероятности.

Часть всех этих людей наполнены волнением на тему того, что искусственный сверхинтеллект мог бы сделать для нас — примерно так же мог быть взволнован Индиана Джонс перед началом поисков утраченного ковчега. Когда все случится, волнение поутихнет или перейдет в другой лейтмотив. Только осторожность и выдержка Индианы Джонса позволяют ему пройти все препятствия, преодолеть все преграды и выйти сухим из воды. Людям в «зоне тревоги» довольно сложно рисковать сломя голову, поэтому они пытаются вести себя осторожно.

Что же именно делает «зону тревоги» тревожной?