Роботам трудно сделать правильный моральный выбор

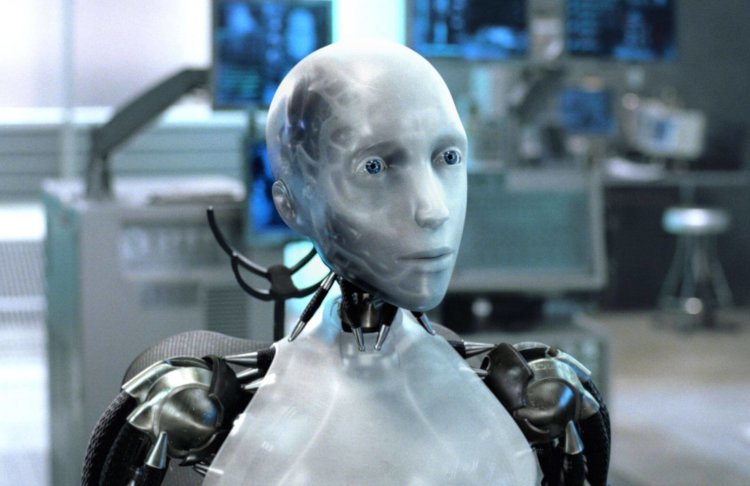

Теперь есть все основания не доверять автомобилям без водителя, которые уже скоро появятся на общественных дорогах. В ходе недавнего эксперимента ученые попытались выяснить, как будут действовать роботы в ситуации, опасной для жизни человека. Результаты удивили исследователей.

Ученые Университета Западной Англии в городе Бристоль обнаружили, что роботы, руководствующиеся этическими принципами, допускают больше смертей. Чаще всего это связано не с трудностью выбора, а слишком долгими размышлениями машины над тем, кого спасать из двух человек, одновременно оказавшихся в опасности.

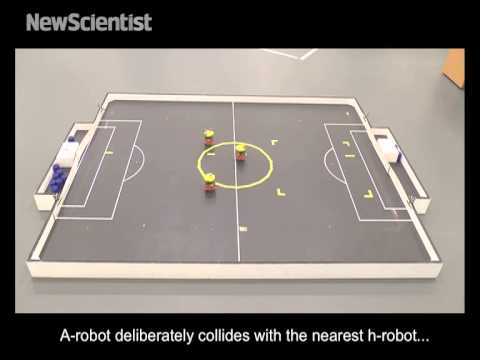

Как пишет газета Daily Mail, в ходе эксперимента один робот должен был предотвратить падение двух других роботов, изображавших людей, в яму. Однако почти в половине случаев «этическая машина» смогла спасти только одну из двух машин. Лишь три раза из тридцати трех ей удалось удержать сразу двоих. В остальных случаях робот тратил слишком много времени на размышления, кого спасть первым. В результате погибали оба «человека».

Согласно законам робототехники, сформулированным фантастом Айзеком Азимовым, робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред. Проблема в том, что это правило не всегда работает. Например, машина может увидеть одного человека и начать двигаться в его сторону, пока в ее поле зрения не окажется другой человек — это заставит спасателя пересмотреть свое поведение. Время, которое можно было бы использовать для спасения одного человека, он потратит на обдумывание ситуации. Результатом его бездействия станет смерть обоих людей. Ученые называют такого робота «этическим зомби».

Результаты эксперимента могут оказать влияние на самоуправляемые автомобили, которым однажды придется стать перед выбором: спасать пассажиров или других участников дорожного движения.

Роботы и люди все теснее взаимодействуют друг с другом. Недавнее исследование показало, что люди работают эффективнее, когда ими управляют роботы.

Новости, статьи и анонсы публикаций

Чат с читателямиСвободное общение и обсуждение материалов